Bit-identische Musik-Dateien auf derselben Festplatte

-

uli.brueggemann

- Aktiver Hersteller

- Beiträge: 4659

- Registriert: 23.03.2009, 15:58

- Wohnort: 33649

- Kontaktdaten:

Uwe,

die Daten werden auf dem langen Weg immer zwischengespeichert, also gepuffert. Es werden zumindest partiell immer feste Zustandsgrößen hergestellt.

Entscheidend ist also was auf dem Weg zum Ohr passiert.

Ich sehe da eine Kette von Einflussmöglichkeiten, die den gewünschten gleichmässig parallelen und kohärenten Ablauf der Datenströme beeinflussen:

- der imer wieder diskutierte Jitter

- elektrische Störgrößen z.B. auch über Masseleitungen

- Aliasingeffekte

- Intermodulationsverzerrungen

Wenn jeder Kanal ein gewisses Eigenleben führt wirkt es sich nachteilig auf die Kohärenz aus. Es gibt dann immer kanalungleiche Abweichungen. Und die stören letztlich unsere Wahrnehmung.

Grüsse

Uli

die Daten werden auf dem langen Weg immer zwischengespeichert, also gepuffert. Es werden zumindest partiell immer feste Zustandsgrößen hergestellt.

Entscheidend ist also was auf dem Weg zum Ohr passiert.

Ich sehe da eine Kette von Einflussmöglichkeiten, die den gewünschten gleichmässig parallelen und kohärenten Ablauf der Datenströme beeinflussen:

- der imer wieder diskutierte Jitter

- elektrische Störgrößen z.B. auch über Masseleitungen

- Aliasingeffekte

- Intermodulationsverzerrungen

Wenn jeder Kanal ein gewisses Eigenleben führt wirkt es sich nachteilig auf die Kohärenz aus. Es gibt dann immer kanalungleiche Abweichungen. Und die stören letztlich unsere Wahrnehmung.

Grüsse

Uli

-

axxxxx

Hallo Uli,

diesen Punkt

Gruß,

Kai

diesen Punkt

hatten wir bislang noch nicht in die Gleichung aufgenommen, er gehört aber zweifelsohne dazu. Auf der rein digitalen Ebene ist es, bis zu einem gewissen Grad, völlig wurscht, wie verjittert die Rechtecksignale daherkommen, solange noch eine zweifelsfrei Unterscheidung zwischen 0 und 1 möglich ist. Aus meiner Sicht, werden die Daten zum ersten Mal ihrer Jungfräulichkeit beraubt, wenn sie von optischen (CD) in magnetische/elektrische Signale umgewandelt werden. Von da an nimmt das Verhängnis seinen Lauf. Getreu dem Motto "garbage in - garbage out" müßte eigentlich der Baustein, der diese erste Wandlung vornimmt einen besonders signifikanten Einfluß auf die Signalqualität haben - oder nicht? Alle weiteren Stationen verschlechtern das Signal weiter oder lassen es im besten Fall so, wie sie es empfangen haben. Und am Ende der Kette sitzt dann der DAC-Chip mit seiner Peripherie.uli.brueggemann hat geschrieben:kanalungleiche Abweichungen

Gruß,

Kai

-

Hans-Martin

- Aktiver Hörer

- Beiträge: 9141

- Registriert: 14.06.2009, 15:45

Hallo Kaiaston456 hat geschrieben: Aus meiner Sicht, werden die Daten zum Erstenmal ihrer Jungfräulichkeit beraubt, wenn sie von optischen (CD) in magnetische/elektrische Signale umgewandelt werden. Von da an nimmt das Verhängnis seinen Lauf.

Dem würde ich fast uneingeschränkt zustimmen. CDRs verhalten sich etwas anders als geprägte CDs, wie wir sie im allgemeinen kaufen, siehe Ulis Beitrag.

Das GI-GO Prinzip lässt sich bei Analog wohl sehr gut anwenden (Rauschen oder echter Signalanteil lassen sich schwer trennen), aber bei Digital ist die Möglichkeit, Jitter zu filtern, eine ernsthafte Methode, etwas besseres herauszubekommen als man hineingegeben hat (Rauschen, gewisse Störungen lassen sich herausfiltern).Getreu dem Motto "garbage in - garbage out" müßte eigentlich der Baustein, der diese erste Wandlung vornimmt einen besonders signifikanten Einfluß auf die Signalqualität haben - oder nicht? Alle weiteren Stationen verschlechtern das Signal weiter oder lassen es im besten Fall so, wie sie es empfangen haben. Und am Ende der Kette sitzt dann der DAC-Chip mit seiner Peripherie.

Dabei fällt mir ein, Cache-Pufferspeicher setzen SRAM ein, diese werden laut Wikipedia als bistabile Kippstufe ausgeführt. Der digitale Zustand wird beim Auslesen nicht geändert, aber die Versorgungsspannung hat eventuell Einfluss auf die Ausgangsspannung des Bausteins.

Grüße Hans-Martin

-

lukivision

- Aktiver Hörer

- Beiträge: 282

- Registriert: 07.03.2014, 09:38

- Wohnort: Bochum

Hallo zusammen,

hier ein paar Gedanken, die ich an anderer Stelle (MQn-thread) auch schon mal dargelegt habe, hier passen sie besser:

Was wir brauchen, ist ein Maß, das die Veränderung im elektrischen Signal auf dem gesamten Weg vom Signalerzeuger (Mikro) bis zum Signalwandler (Lautsprecher) durch alle Stufen hindurch darstellt. Und ich meine hier ein Maß, das durch eine Einheit wie einem Meter oder einem Volt ausgedrückt werden kann. Für uns aktive Hörer wäre natürlich insbesondere die Veränderung auf dem Teilweg relevant, der die Wiedergabe des gespeicherten Produkts (z.B. die Musikdatei) betrifft. Denn sich alleine auf seine Ohren zu verlassen, mag für einen selber genügen, ist aber wahrnehmungsgetrübt und dadurch nicht allgemein vergleichbar. Hier wäre evtl. ein Forschungsprojekt hilfreich, vielleicht könnte sich damit noch jemand Lorbeeren verdienen.

Ausgangspunkt ist, daß wir es mit Elektrizität zu tun haben. Auch eine digitale Übertragung bedient sich analoger Wege. Strom an (die "1" in der digitalen Betrachtung), Strom aus (die "0"). Hier ist die Herausforderung, die Anstiegszeit möglichst kurz, den anschließenden stromführenden Zeitraum ("1") möglichst gleichmäßig stark und auch in der absolut korrekten zeitlichen Dauerzu halten und schließlich den Strom genau so plötzlich wie er gekommen ist wieder auszuschalten. Die Pause bis zum nächsten Einschalten ("0") muß ebenfalls peinlichst genau so lang sein wie die der Zeitraum "1". Das ist die oft gezeigte Rechteckform des "digitalen" Signals. In der Praxis scheint das in dieser reinen Ausprägung nicht machbar zu sein. In der Praxis haben wir es nicht mit rechten Winkeln, sondern mit gerundeten Formen zu tun, deren Intervalle obendrein nicht alle gleich lang sind. Aus diesem Grunde braucht es Kompensationsglieder in der Kette, die diese leichten Fehler mal mehr, mal weniger gut korrigieren (auf der Zeitebene machen das oft Quarze, die "clocks")

Jedes Glied in der Kette führt aber zu subtilen Veränderungen im ursprünglichen Signal. Es mag Elemente geben, die sich positiv auswirken, es mag welche geben, die sich negativ auswirken. Es wird nur wenige geben, die sich überhaupt nicht auswirken, die sich neutral verhalten. Im besten Falle heben sich negative und positive Veränderungen auf. So ist zu erklären, daß sich ein Gerät in dieser Kette positiv bemerkbar macht und in einer anderen Kette negativ.

Wenn wir uns einig sind, daß das Signal auf seinem langen Weg bis zum Lautsprecher ganz sicher manipuliert wird, ist als nächstes zu klären, welche Kriterien klangbestimmend sind. Dies sind ganz sicher nicht nur Frequenzgang, Impulsantwort, Lautstärke. Hier kommen auch diese schwierig zu fassenden Begriffe wie Räumlichkeit, Transparenz, Musikalität usw. ins Spiel. Welche elektrischen Eigenschaften sind dafür verantwortlich? Denn es müssen elektrisch meßbare Qualitäten sein, da es sich immer um ein elektrisches Signal handelt. Diese Fragen müßten vorab geklärt werden - ein etwas längerer, aber dennoch lohnender und spannender Prozeß.

Das Maß dieser einzelnen Veränderung/Beeinflussung messen zu können, wäre eine Riesenhilfe. Sowohl für uns Hörer als auch für die Entwickler. Es muß eigentlich meßbar sein, weil es sich um Veränderungen im elektrischen Signal handelt. Immerhin sind sie hörbar, also wahrnehmbar. Die Aufgabe der Ingenieure wäre nun, Kriterien zu entwickeln, diese Veränderungen/Abweichungen zweifelsfrei und eindeutig zu identifizieren. Und vielleicht braucht es genau dazu eine neue Maßeinheit - vielleicht ein Fujak. Man würde dann sagen, dieses Gerät beeinflußt das Signal um 2,4 Fujak, jenes um -3,6 Fujak usw.

Luki

hier ein paar Gedanken, die ich an anderer Stelle (MQn-thread) auch schon mal dargelegt habe, hier passen sie besser:

Was wir brauchen, ist ein Maß, das die Veränderung im elektrischen Signal auf dem gesamten Weg vom Signalerzeuger (Mikro) bis zum Signalwandler (Lautsprecher) durch alle Stufen hindurch darstellt. Und ich meine hier ein Maß, das durch eine Einheit wie einem Meter oder einem Volt ausgedrückt werden kann. Für uns aktive Hörer wäre natürlich insbesondere die Veränderung auf dem Teilweg relevant, der die Wiedergabe des gespeicherten Produkts (z.B. die Musikdatei) betrifft. Denn sich alleine auf seine Ohren zu verlassen, mag für einen selber genügen, ist aber wahrnehmungsgetrübt und dadurch nicht allgemein vergleichbar. Hier wäre evtl. ein Forschungsprojekt hilfreich, vielleicht könnte sich damit noch jemand Lorbeeren verdienen.

Ausgangspunkt ist, daß wir es mit Elektrizität zu tun haben. Auch eine digitale Übertragung bedient sich analoger Wege. Strom an (die "1" in der digitalen Betrachtung), Strom aus (die "0"). Hier ist die Herausforderung, die Anstiegszeit möglichst kurz, den anschließenden stromführenden Zeitraum ("1") möglichst gleichmäßig stark und auch in der absolut korrekten zeitlichen Dauerzu halten und schließlich den Strom genau so plötzlich wie er gekommen ist wieder auszuschalten. Die Pause bis zum nächsten Einschalten ("0") muß ebenfalls peinlichst genau so lang sein wie die der Zeitraum "1". Das ist die oft gezeigte Rechteckform des "digitalen" Signals. In der Praxis scheint das in dieser reinen Ausprägung nicht machbar zu sein. In der Praxis haben wir es nicht mit rechten Winkeln, sondern mit gerundeten Formen zu tun, deren Intervalle obendrein nicht alle gleich lang sind. Aus diesem Grunde braucht es Kompensationsglieder in der Kette, die diese leichten Fehler mal mehr, mal weniger gut korrigieren (auf der Zeitebene machen das oft Quarze, die "clocks")

Jedes Glied in der Kette führt aber zu subtilen Veränderungen im ursprünglichen Signal. Es mag Elemente geben, die sich positiv auswirken, es mag welche geben, die sich negativ auswirken. Es wird nur wenige geben, die sich überhaupt nicht auswirken, die sich neutral verhalten. Im besten Falle heben sich negative und positive Veränderungen auf. So ist zu erklären, daß sich ein Gerät in dieser Kette positiv bemerkbar macht und in einer anderen Kette negativ.

Wenn wir uns einig sind, daß das Signal auf seinem langen Weg bis zum Lautsprecher ganz sicher manipuliert wird, ist als nächstes zu klären, welche Kriterien klangbestimmend sind. Dies sind ganz sicher nicht nur Frequenzgang, Impulsantwort, Lautstärke. Hier kommen auch diese schwierig zu fassenden Begriffe wie Räumlichkeit, Transparenz, Musikalität usw. ins Spiel. Welche elektrischen Eigenschaften sind dafür verantwortlich? Denn es müssen elektrisch meßbare Qualitäten sein, da es sich immer um ein elektrisches Signal handelt. Diese Fragen müßten vorab geklärt werden - ein etwas längerer, aber dennoch lohnender und spannender Prozeß.

Das Maß dieser einzelnen Veränderung/Beeinflussung messen zu können, wäre eine Riesenhilfe. Sowohl für uns Hörer als auch für die Entwickler. Es muß eigentlich meßbar sein, weil es sich um Veränderungen im elektrischen Signal handelt. Immerhin sind sie hörbar, also wahrnehmbar. Die Aufgabe der Ingenieure wäre nun, Kriterien zu entwickeln, diese Veränderungen/Abweichungen zweifelsfrei und eindeutig zu identifizieren. Und vielleicht braucht es genau dazu eine neue Maßeinheit - vielleicht ein Fujak. Man würde dann sagen, dieses Gerät beeinflußt das Signal um 2,4 Fujak, jenes um -3,6 Fujak usw.

Luki

-

uli.brueggemann

- Aktiver Hersteller

- Beiträge: 4659

- Registriert: 23.03.2009, 15:58

- Wohnort: 33649

- Kontaktdaten:

Luki,

Dein Beitrag betrachtet den gesamten Weg - und verkompliziert damit noch alles.

Der Topic sieht aber im Prinzip eine unveränderte Signalkette (wie immer sie beschaffen sein mag) mit einer einzigen Ausnahme. Nämlich dass bit-identische Dateien (ein Vergleich der Dateien zeigt dies), also mit unterschiedlicher Position auf irgendeinem Speichermedium, ansonstem identischem Inhaltszustand, wohl trotzdem anders klingen. Die nachfolgende Wiedergabekette ist dabei anscheinend nicht in der Lage, dies zu kompensieren. Das könnte man denn auch so betrachten, dass sie also nix taugt.

Und es stellt sich so die Frage, was bewirkt denn nun den Unterschied ? Bei der nachfolgend gleichen Wiedergabekette. Was geht da ab, was könnte dahinter stecken und wie kann man es denn auch einmal konkret NACHWEISEN?

Grüsse

Uli

Dein Beitrag betrachtet den gesamten Weg - und verkompliziert damit noch alles.

Der Topic sieht aber im Prinzip eine unveränderte Signalkette (wie immer sie beschaffen sein mag) mit einer einzigen Ausnahme. Nämlich dass bit-identische Dateien (ein Vergleich der Dateien zeigt dies), also mit unterschiedlicher Position auf irgendeinem Speichermedium, ansonstem identischem Inhaltszustand, wohl trotzdem anders klingen. Die nachfolgende Wiedergabekette ist dabei anscheinend nicht in der Lage, dies zu kompensieren. Das könnte man denn auch so betrachten, dass sie also nix taugt.

Und es stellt sich so die Frage, was bewirkt denn nun den Unterschied ? Bei der nachfolgend gleichen Wiedergabekette. Was geht da ab, was könnte dahinter stecken und wie kann man es denn auch einmal konkret NACHWEISEN?

Grüsse

Uli

-

axxxxx

Hallo Uli,

das

Und auch wenn es ja einige Hartgesottene nicht glauben wollen: Wenn man einen Unterschied hören kann, dann kann man diesen auch meßtechnisch nachweisen. Möglicherweise reicht die Genauigkeit der heutigen Meßgeräte dafür noch nicht aus oder es wird schlichtweg das Falsche gemessen, aber möglich sein muß es. Die Flanken und das Timing sind eines, aber vielleicht hat der Rauschteppich um das eigentliche Nutzsignal eine wesentlich höhere Bedeutung, als man bisher annimmt, vielleicht ist er aber auch komplett wurscht.

Gruß,

Kai

das

scheint mir der springende Punkt zu sein. Denn dann könnte man wohl auch eher ansetzen, wie man sicherstellen kann, daß ein zunächst jungfräulich perfektes Signal es über den Weg auch bleibt.uli.brueggemann hat geschrieben:NACHWEISEN

Und auch wenn es ja einige Hartgesottene nicht glauben wollen: Wenn man einen Unterschied hören kann, dann kann man diesen auch meßtechnisch nachweisen. Möglicherweise reicht die Genauigkeit der heutigen Meßgeräte dafür noch nicht aus oder es wird schlichtweg das Falsche gemessen, aber möglich sein muß es. Die Flanken und das Timing sind eines, aber vielleicht hat der Rauschteppich um das eigentliche Nutzsignal eine wesentlich höhere Bedeutung, als man bisher annimmt, vielleicht ist er aber auch komplett wurscht.

Gruß,

Kai

-

dark cloud

- Aktiver Hörer

- Beiträge: 128

- Registriert: 04.04.2014, 11:32

- Wohnort: Orbit Düsseldorf

Hallo zusammen,

irgendwie kann ich der Diskussion nicht folgen.

1. Der Informationsgehalt einer über ein Compi-Laufwerk gerippten Datei und der über einen CD-Player ausgelesenen Datei, welche direkt einem DA-Wandler zugeführt wird, können u.U. unterschiedliche Informationen enthalten, was dem unterschiedlichen Aus- bzw. Einleseprozess (z.B. Interpolation beim CD-LW) geschuldet ist.

2. Wenn die Daten einmal auf der Festplatte angekommen sind, gibt es kein (!) Datenverlust mehr. Wie soll sonst Powerpoint, Ecxel usw. dauerhaft funktionieren.

3. Das Auslesen der Daten von der Festplatte und die Zwischenspeicherung im Arbeitsspeicher geschieht so schnell, dass hier der Zeitversatz keine Rolle spielt. Die Daten werden erst zum Ausgang/Schnittstelle durchgereicht, wenn die Daten vollständig im Arbeitsspeicher vorliegen. Von daher spielt es auch keine Rolle ob die Festplatte voll oder leer ist oder es sich um eine SSD handelt. Habe ich bei mir ausprobiert, und keine Unterschiede im Klang feststellen können.

4. Unterschiede im Klang können aus meiner Sicht nur durch unterschiedliche elektronische Bauteile zwischen Wandler und Laufwerk/Compi entstehen (zusätzlicher Jitter durch Kabel oder sonstige Bauteile vom Compi zum Wandler).

Nehme ich den Reclocker zwischen Wandler und Compi raus, ist der Compi-Klang klar im Nachteil. Erst mit Reclocker spielen LW und Compi auf Augenhöhe.

Sorry, vielleicht bin ich zu einfach unterwegs.

Gruß

irgendwie kann ich der Diskussion nicht folgen.

1. Der Informationsgehalt einer über ein Compi-Laufwerk gerippten Datei und der über einen CD-Player ausgelesenen Datei, welche direkt einem DA-Wandler zugeführt wird, können u.U. unterschiedliche Informationen enthalten, was dem unterschiedlichen Aus- bzw. Einleseprozess (z.B. Interpolation beim CD-LW) geschuldet ist.

2. Wenn die Daten einmal auf der Festplatte angekommen sind, gibt es kein (!) Datenverlust mehr. Wie soll sonst Powerpoint, Ecxel usw. dauerhaft funktionieren.

3. Das Auslesen der Daten von der Festplatte und die Zwischenspeicherung im Arbeitsspeicher geschieht so schnell, dass hier der Zeitversatz keine Rolle spielt. Die Daten werden erst zum Ausgang/Schnittstelle durchgereicht, wenn die Daten vollständig im Arbeitsspeicher vorliegen. Von daher spielt es auch keine Rolle ob die Festplatte voll oder leer ist oder es sich um eine SSD handelt. Habe ich bei mir ausprobiert, und keine Unterschiede im Klang feststellen können.

4. Unterschiede im Klang können aus meiner Sicht nur durch unterschiedliche elektronische Bauteile zwischen Wandler und Laufwerk/Compi entstehen (zusätzlicher Jitter durch Kabel oder sonstige Bauteile vom Compi zum Wandler).

Nehme ich den Reclocker zwischen Wandler und Compi raus, ist der Compi-Klang klar im Nachteil. Erst mit Reclocker spielen LW und Compi auf Augenhöhe.

Sorry, vielleicht bin ich zu einfach unterwegs.

Gruß

-

Hans-Martin

- Aktiver Hörer

- Beiträge: 9141

- Registriert: 14.06.2009, 15:45

Dazu habe ich gerade in einem anderen Forum von Barry Diament (der Led Zeppelin I gemastert hat) Folgendes gelesen, das er vor 2h gepostet hat:aston456 hat geschrieben:Aus meiner Sicht, werden die Daten zum ersten Mal ihrer Jungfräulichkeit beraubt, wenn sie von optischen (CD) in magnetische/elektrische Signale umgewandelt werden. Von da an nimmt das Verhängnis seinen Lauf.

Auch wenn die Forumsstatuten gebieten, keine Querverweise auf andere Forumsdiskussionen zu machen, fand ich diesen Beitrag passend zu diesem Aspekt (wenn auch nicht zum Thread), zumal er von einem alten Haudegen kommt, der immer noch im Business ist, auch wenn seine Arbeit schon unsere Jugend beeinflusst hat...Barry Diament hat geschrieben:To be clear, I was saying that a properly done CD rip sounds like the master from which the CD is created. That is to say, the CD master.

It is easy to get confused by the term master. To wit:

1. The original recording, made when the musicians were playing is the master.

2. If that recording was made using mulitple channels/tracks (as most, but not all are), it will get mixed down to stereo and the result is the master.

3. For many recordings, the next stop may be the editing room (which is sometimes also the mastering room). Here, all sorts of "surgery" can occur -- anything from simple trimming of the "heads and tails" (banter before the song actually starts or after it ends) to stitching together parts of different takes to assemble a "whole" song. When it is all done, the result is called the master.

4. The finished recording (either the original or the edited or mixed master) is then edited, if necessary and taken to a mastering room, where the engineer will create -- you guessed it -- the master.

(Is everyone getting this? It *will* be on the test. ;-})

It is generally that last master that is used to create the replicated discs (or files or tapes) we purchase. Sometimes, on rare occasions, the first master is the one that is used to create the replicated versions. This is often referred to as a "flat transfer" however, these are desirable only to folks who have never heard many original master recordings. Put simply, when one considers how most recordings are made, it is not at all surprising that they need help. That is where the mastering engineer comes in.

Even super purist recordings, which may sound wonderful straight out of the microphones, will benefit from mastering. The reason is that getting the best recording possible involves leaving lots of headroom. Every monolithic A-D converter in my experience will deliver its best performance (i.e. lowest distortion) when the original A-D conversion levels are no "hotter" than -6 dBFS. There may be good arguments for keeping the maximum peak even lower, perhaps -10 or -15. Certainly with properly designed 24-bit recording gear, this does not exact any significant price and *does* provide significant benefits. Once in the digital domain however, one can take advantage of all the "real estate" and raise the maximum peak level up as high as perhaps -0.3 dBFS. (Anyone who has done this for a while will think of 0 dB as the equivalent of an overload since many D-A converters will "stick" if they encounter 0 peaks. In addition, what was not so widely known in the early days -- and is still unknown, or worse, ignored, in some quarters -- is that there are the intersample peaks to consider, so depending on the dynamics of the program material, I'd never let the levels get above -0.3.) So, even a super purist recording will benefit from a stop in the mastering room. In addition, this is usually where an album is sequenced and the spacing (timing) between tracks is decided, to create the overall flow of an album.

As you can see, having any file sound like the original master is not such a great idea.

What it needs to sound like, in my opinion, is the master from which it was made. In this regard, I have never heard a pressed disc (analog or digital), even from the very best pressing plants or replicators that fulfills this.

When I started Soundkeeper, I spoke with folks at dozens of CD replicators all over the world - most of whom I'd sent masters over the years. All but one told me their CDs will "sound exactly like the master". Based on my experience that this has never been the case even once out of what must be several thousand CD masters I've sent out over the years, I thanked them for their time and moved on. Only one person at one plant - with no prompting from me whatsoever - said "Oh no, the CD will never sound exactly like the master." I have been sending this plant all my work ever since.

When I master an album, I basically "live with" it at an intense level. I hear it over and over and over again and become intimately familiar with its sound and all of its quirks. When CDs come back from other plants (depending on who the client is working with), I can hear the loss of focus and fine detail almost immediately and quite plainly. With CDs from the plant I mentioned above, I need a synchronized playback with the CD master in order to discern what differences remain -- a subtle loss of what focus and fine detail are on the CD master, regardless of the transport or player I try.

Interestingly, this plant does a few things differently. One of the first stages of CD replication is the cutting of the glass master from the CD master sent to the plant. The glass master gets electroplated and the result goes on to the next stage of production. Where most plants cut their glass at high speed, this one cuts the glass in real time (1x). (This reminds me of my experience burning CD-Rs in that the slow burns are the ones that have always been the most faithful to the CD master.) In addition, where most plants use an injection molding cycle of ~4.5 seconds, this plant uses a 9 second cycle. Perhaps the pits are better formed? I can't say for sure but what I *can* say is I find their CDs the closest of any discs in my experience, to the masters from which they are made.

Still, take one of those and properly rip it to .aif (or .wav) and what differences between disc playback and the CD master exist when listening via a transport or player, simply go away and one has the sound of the (finished, mastered, final) master.

Best regards,

Barry

http://www.soundkeeperrecordings.com

http://www.soundkeeperrecordings.wordpress.com

http://www.barrydiamentaudio.com

Grüße Hans-Martin

Hallo Forenten,

da hat sich ja schon eine rege Diskussion ergeben (wenn auch nicht immer streng zum Thema).

Ich will mal versuchen, einige meiner allgemeinen Bemerkungen im Startbeitrag, mit Hilfe von ein paar Bildern zu ergänzen.

Betrachten wir diese (abstrakte) Folge von 10 Bits: 1101000101

Wenn wir die mit einem elektrischen Signal übertragen wollen, würden wir uns vielleicht so einen schönen Amplitudenverlauf wünschen; pro Bit ist die Amplitude eine Zeiteinheit lang auf einem festen positiven oder negativen Wert (mit unendlich schnellen Wechseln), Version 1:

[img]http://frank_l.bitbucket.org/fsuyaflwhfsauy/version1.png[/img]

So lässt sich das in der physikalischen Wirklichkeit allerdings nicht realisieren; die Wechsel zwischen positiv und negativ brauchen eine Weile, und eventuell kann die Amplitude nicht ganz stabil gehalten werden und die Zeitpunkte für die Wechsel werden nicht ganz präzise eingehalten. Also sieht es vielleicht eher so aus (Version 2):

[img]http://frank_l.bitbucket.org/fsuyaflwhfsauy/version2.png[/img]

Na ja, die beteiligten Bauteile haben vielleicht nur eine mäßig stabile Spannungsversorgung und es gibt Übersprechen von anderen Bauteilen oder Leitungen, dann sieht es sogar eher so aus (Version 3):

[img]http://frank_l.bitbucket.org/fsuyaflwhfsauy/version3.png[/img]

Und selbst das ist für einige tatsächlich exisitierenden Bauteile bestimmt noch eine ziemlich idealisierte Vorstellung, hier ist Version 4:

[img]http://frank_l.bitbucket.org/fsuyaflwhfsauy/version4.png[/img]

Ist jetzt Version 4 "schlechter" als Version 1?

Für den Informatiker, der einfach nur die Bitfolge verlustfrei übertragen will: NEIN, alle vier Versionen sind gleich gut! Bei jeder der Kurven ist ganz eindeutig in jedem Zeitintervall festzustellen, ob die Amplitude überwiegend positiv oder negativ ist (mathematisch: das Integral über ein Zeitintervall positiv oder negativ ist). Bei allen Versionen ist die ursprüngliche Bitfolge klar zu 100% rekonstruierbar.

Für die Informatiker und Computerbauer ist eine "Verbesserung" von Version 4 auf Version 1 gar kein Thema, weil unnötig. Es kommt drauf an, dass das Signal billig, schnell und mit reproduzierbarer Erfolgswahrscheinlichkeit übertragen werden kann. (Ja, es kann sogar akzeptabel sein, dass nur 99,99999% der Bits korrekt rekonstruiert werden; mit Hilfe von Codierungstheorie kann man dann trotzdem Daten mit beliebiger Verlässlichkeit transportieren. Zum Beispiel sind auch bei kleinen Kratzern oder Staub auf einer CD alle Bits rekonstruierbar; oder in einem Festplatten-RAID-System kann eine Platte komplett ausfallen - was ja auch tatsächlich gelegentlich passiert - ohne, dass Daten verloren gehen.)

Also, für Informatiker ist alles bestens.

Was aber, wenn das diskutierte Signal an den Eingang eines DAC Chips angelegt werden soll? So ein Chip ist ja im Grunde ein analoges Bauteil, auf der einen Seite kommt ein analoges Signal an (bit-genau, es kann zu 100% die abstrakte digitale Information daraus korrekt abgelesen werden, egal ob wir Version 1 oder Version 4 anlegen) und auf der anderen Seite kommt ein analoges Audio-Signal raus. Und dieses analoge Ausgangs-Signal hängt eben LEIDER nicht nur von den Bits ab, die das Eingangssignal kodiert, sondern wird auch von der Wellenform des Eingangssignals beeinflusst. Auf einer guten Anlage wird vermutlich Version 1 ein signifikant angenehmeres Hörerlebnis bieten als Version 4. Zum Musikhören sind wir also an einer Eigenschaft des Signals für den DAC-Chip interessiert, die für die Informatiker (zurecht) völlig irrelevant ist.

Wenn ich es richtig verstanden habe, ist das Wichtigste für die Ausgabeaqualität des DAC-Chips, dass der Chip die Wechsel von 0 zu 1 oder umgekehrt in der Bitfolge möglichst genau zu den vorgesehenen Zeitpunkten (wo in Version 1 die senkrechten Striche sind) registriert. Die eigentliche Wellenform ist vielleicht weniger wichtig, hochfrequentes Rauschen ist vielleicht auch nicht so gut für die Ausgabe - aber in den physikalisch-technischen Details kenne ich mich nicht aus.

Schätzen wir mal grob ab: Eine CD enthält pro Kanal 44100*16 = etwa 700000 Bits an Informationen pro Sekunde. Wenn ein Rechner mit 1 Ghz getaktet ist, so vergehen pro Bit etwa 1400 Taktzyklen. Im Durchschnitt wird das über längere Zeit sehr genau eingehalten, aber man kann sich schon vorstellen, dass es bei der Datenverarbeitung im Computer im Kleinen das ganz schöne Schwankungen gibt. Die Bits werden einfach nicht in extrem gleichmäßigen Takten Bit für Bit verarbeitet. Wie in den ersten Beiträgen diskutiert, kann die Zeit zum Lesen eines Datenwortes von der Festplatte sicher stark schwanken, nicht alle Speicherstellen des Arbeitsspeichers können von den verschiedenen CPU-Cores gleich schell angesprochen werden, Daten werden blockweise über Puffer transportiert, usw. ... In den Playerprogrammen, die ich geschrieben habe, versuche ich genau hier einzugreifen und den Datenfluss gleichmäßiger zu machen.

Ich möchte hier nochmal einen fundamentalen Unterschied zwischen einem analogen und einem digitalen Audiosignal herausstellen: Wären die Kurven oben ein analoges Audiosignal, das in Version 1 sehr sauber ist und in Version 2 bis 4 zunehmend verhunzt wird, dann verlieren wir UNWIEDERBRINGLICH Informationen des Originalsignals. Auf einem rein analogen Signalpfad vom Instrument über Mikro, Kopieren, Mixen, Tonträger und Wiedergabe wird das Signal unweigerlich immer schlechter (im dem Sinne, dass Information des Originals verloren geht). Wenn das Signal in dieser Kette aber einmal digitalisiert wurde, dann können wir diese abstrakte digitale Information beliebig kopieren, speichern, vervielfältigen, transportieren (auch mit Version 4), ohne das irgendeine Information verloren geht. (Die Aufnahme wird in der Regel noch bearbeitet, gemixt, usw., aber man kann immer ohne Verlust zum Ausgangsmaterial zurück und von vorne anfangen.)

Worum es in diesem Thread an einem Beipiel geht, ist die Frage, inwieweit die Art unserer digitalen (Musik-)Datenspeicherung und -Verarbeitung einen Einfluß auf die analoge Signalkurve hat, die am Ende zum Abspielen beim DAC-Chip ankommt. Wir können davon ausgehen, dass (solange nicht wirklich irgendetwas kaputt ist) diese Signalkurve die korrekten Bits kodiert, die wir an den DAC schicken wollen.

Das Ziel solcher Diskussionen sollte am Ende sein, Ideen zu entwickeln, wie wir die analoge Signalqualität am DAC (möglichst nahe Richtuung Version 1) verbessern können, indem wir das Signal, das dort ankommt, möglichst gut von seiner "Geschichte" entkoppeln. Und das Gute ist, dass das in der digitalen Welt im Prinzip möglich ist. Aber mit meinem Versuch habe ich herausgefunden, dass Speichern auf einer Festplatte und wieder auslesen so eine Entkoppelung nicht leistet.

Viele Grüße,

Frank

da hat sich ja schon eine rege Diskussion ergeben (wenn auch nicht immer streng zum Thema).

Ich will mal versuchen, einige meiner allgemeinen Bemerkungen im Startbeitrag, mit Hilfe von ein paar Bildern zu ergänzen.

Betrachten wir diese (abstrakte) Folge von 10 Bits: 1101000101

Wenn wir die mit einem elektrischen Signal übertragen wollen, würden wir uns vielleicht so einen schönen Amplitudenverlauf wünschen; pro Bit ist die Amplitude eine Zeiteinheit lang auf einem festen positiven oder negativen Wert (mit unendlich schnellen Wechseln), Version 1:

[img]http://frank_l.bitbucket.org/fsuyaflwhfsauy/version1.png[/img]

So lässt sich das in der physikalischen Wirklichkeit allerdings nicht realisieren; die Wechsel zwischen positiv und negativ brauchen eine Weile, und eventuell kann die Amplitude nicht ganz stabil gehalten werden und die Zeitpunkte für die Wechsel werden nicht ganz präzise eingehalten. Also sieht es vielleicht eher so aus (Version 2):

[img]http://frank_l.bitbucket.org/fsuyaflwhfsauy/version2.png[/img]

Na ja, die beteiligten Bauteile haben vielleicht nur eine mäßig stabile Spannungsversorgung und es gibt Übersprechen von anderen Bauteilen oder Leitungen, dann sieht es sogar eher so aus (Version 3):

[img]http://frank_l.bitbucket.org/fsuyaflwhfsauy/version3.png[/img]

Und selbst das ist für einige tatsächlich exisitierenden Bauteile bestimmt noch eine ziemlich idealisierte Vorstellung, hier ist Version 4:

[img]http://frank_l.bitbucket.org/fsuyaflwhfsauy/version4.png[/img]

Ist jetzt Version 4 "schlechter" als Version 1?

Für den Informatiker, der einfach nur die Bitfolge verlustfrei übertragen will: NEIN, alle vier Versionen sind gleich gut! Bei jeder der Kurven ist ganz eindeutig in jedem Zeitintervall festzustellen, ob die Amplitude überwiegend positiv oder negativ ist (mathematisch: das Integral über ein Zeitintervall positiv oder negativ ist). Bei allen Versionen ist die ursprüngliche Bitfolge klar zu 100% rekonstruierbar.

Für die Informatiker und Computerbauer ist eine "Verbesserung" von Version 4 auf Version 1 gar kein Thema, weil unnötig. Es kommt drauf an, dass das Signal billig, schnell und mit reproduzierbarer Erfolgswahrscheinlichkeit übertragen werden kann. (Ja, es kann sogar akzeptabel sein, dass nur 99,99999% der Bits korrekt rekonstruiert werden; mit Hilfe von Codierungstheorie kann man dann trotzdem Daten mit beliebiger Verlässlichkeit transportieren. Zum Beispiel sind auch bei kleinen Kratzern oder Staub auf einer CD alle Bits rekonstruierbar; oder in einem Festplatten-RAID-System kann eine Platte komplett ausfallen - was ja auch tatsächlich gelegentlich passiert - ohne, dass Daten verloren gehen.)

Also, für Informatiker ist alles bestens.

Was aber, wenn das diskutierte Signal an den Eingang eines DAC Chips angelegt werden soll? So ein Chip ist ja im Grunde ein analoges Bauteil, auf der einen Seite kommt ein analoges Signal an (bit-genau, es kann zu 100% die abstrakte digitale Information daraus korrekt abgelesen werden, egal ob wir Version 1 oder Version 4 anlegen) und auf der anderen Seite kommt ein analoges Audio-Signal raus. Und dieses analoge Ausgangs-Signal hängt eben LEIDER nicht nur von den Bits ab, die das Eingangssignal kodiert, sondern wird auch von der Wellenform des Eingangssignals beeinflusst. Auf einer guten Anlage wird vermutlich Version 1 ein signifikant angenehmeres Hörerlebnis bieten als Version 4. Zum Musikhören sind wir also an einer Eigenschaft des Signals für den DAC-Chip interessiert, die für die Informatiker (zurecht) völlig irrelevant ist.

Wenn ich es richtig verstanden habe, ist das Wichtigste für die Ausgabeaqualität des DAC-Chips, dass der Chip die Wechsel von 0 zu 1 oder umgekehrt in der Bitfolge möglichst genau zu den vorgesehenen Zeitpunkten (wo in Version 1 die senkrechten Striche sind) registriert. Die eigentliche Wellenform ist vielleicht weniger wichtig, hochfrequentes Rauschen ist vielleicht auch nicht so gut für die Ausgabe - aber in den physikalisch-technischen Details kenne ich mich nicht aus.

Schätzen wir mal grob ab: Eine CD enthält pro Kanal 44100*16 = etwa 700000 Bits an Informationen pro Sekunde. Wenn ein Rechner mit 1 Ghz getaktet ist, so vergehen pro Bit etwa 1400 Taktzyklen. Im Durchschnitt wird das über längere Zeit sehr genau eingehalten, aber man kann sich schon vorstellen, dass es bei der Datenverarbeitung im Computer im Kleinen das ganz schöne Schwankungen gibt. Die Bits werden einfach nicht in extrem gleichmäßigen Takten Bit für Bit verarbeitet. Wie in den ersten Beiträgen diskutiert, kann die Zeit zum Lesen eines Datenwortes von der Festplatte sicher stark schwanken, nicht alle Speicherstellen des Arbeitsspeichers können von den verschiedenen CPU-Cores gleich schell angesprochen werden, Daten werden blockweise über Puffer transportiert, usw. ... In den Playerprogrammen, die ich geschrieben habe, versuche ich genau hier einzugreifen und den Datenfluss gleichmäßiger zu machen.

Ich möchte hier nochmal einen fundamentalen Unterschied zwischen einem analogen und einem digitalen Audiosignal herausstellen: Wären die Kurven oben ein analoges Audiosignal, das in Version 1 sehr sauber ist und in Version 2 bis 4 zunehmend verhunzt wird, dann verlieren wir UNWIEDERBRINGLICH Informationen des Originalsignals. Auf einem rein analogen Signalpfad vom Instrument über Mikro, Kopieren, Mixen, Tonträger und Wiedergabe wird das Signal unweigerlich immer schlechter (im dem Sinne, dass Information des Originals verloren geht). Wenn das Signal in dieser Kette aber einmal digitalisiert wurde, dann können wir diese abstrakte digitale Information beliebig kopieren, speichern, vervielfältigen, transportieren (auch mit Version 4), ohne das irgendeine Information verloren geht. (Die Aufnahme wird in der Regel noch bearbeitet, gemixt, usw., aber man kann immer ohne Verlust zum Ausgangsmaterial zurück und von vorne anfangen.)

Worum es in diesem Thread an einem Beipiel geht, ist die Frage, inwieweit die Art unserer digitalen (Musik-)Datenspeicherung und -Verarbeitung einen Einfluß auf die analoge Signalkurve hat, die am Ende zum Abspielen beim DAC-Chip ankommt. Wir können davon ausgehen, dass (solange nicht wirklich irgendetwas kaputt ist) diese Signalkurve die korrekten Bits kodiert, die wir an den DAC schicken wollen.

Das Ziel solcher Diskussionen sollte am Ende sein, Ideen zu entwickeln, wie wir die analoge Signalqualität am DAC (möglichst nahe Richtuung Version 1) verbessern können, indem wir das Signal, das dort ankommt, möglichst gut von seiner "Geschichte" entkoppeln. Und das Gute ist, dass das in der digitalen Welt im Prinzip möglich ist. Aber mit meinem Versuch habe ich herausgefunden, dass Speichern auf einer Festplatte und wieder auslesen so eine Entkoppelung nicht leistet.

Viele Grüße,

Frank

Hallo Udo,never hat geschrieben: dieser Thread regt natürlich nicht nur zum Diskutieren, sondern auch zum Ausprobieren an.

ja, so soll es sein!

Es haben ja schon einige Leute geantwortet und bemerkt, dass sie und andere nach Austausch einer Festplatte gegen eine SSD eine Klangverbesserung festgestellt haben. Es ist also gut möglich, dass in einem an sonst gleichen Setup eine SSD "besser klingen" kann (weil sie, wie in meinem vorherigen Beitrag beschrieben, mithilft, ein saubereres analoges Signal für den digitalen Input des DAC zu generieren).never hat geschrieben: Ohne nochmals auf alle Variablen eingehen zu wollen, die beim oder auch nach dem Rippen Einfluss auf die Wiedergabequalität digitaler Audiodateien haben können, möchte ich nur kurz auf eine weitere Überraschung hinweisen, die ich vorher noch nicht in dieser Form kennengelernt hatte.

[...]

Wieso klingt die Kopie besser als das Original? Für Antworten wäre ich dankbar.

Aber ich wollte noch anmerken, dass man aus der von Dir beschriebenen Versuchsanordnung alleine nicht gleich auf "SSD ist besser als Festplatte" schließen sollte. Denn Du hast ja mehr gemacht, als nur Festplatte gegen SSD getauscht: Es werden andere Treiber und Interrupts zum Lesen der Daten benutzt, einmal mit und einmal ohne USB-Kabel, und es könnte vielleicht sein, dass eine bessere Stromversorgung Deines WD My Books eine stärkere Verbesserung gäbe. Wenn mehrere Parameter gleichzeitig geändert werden, ist nicht so klar, welcher Parameter den größten Anteil an der gehörten Klangveränderung hat. (An diesem Punkt kranken meiner Meinung nach viele Vergleichstests, über die man in Zeitschriften oder im Internet liest.)

Viele Grüße,

Frank

Hallo Harald,nihil.sine.causa hat geschrieben:Bei den Datenmengen ist das für die "Betriebssituation" verständlich. Da Du aber ja sowieso alles per Script bedienst, könntest Du Dir die abzuspielenden Dateien auch vorher auf eine anderes Medium kopieren und nach dem Abspielen auch wieder löschen.frankl hat geschrieben:Leider habe ich keine SSD, um diesen Versuch zu machen (und habe in naher Zukunft auch nicht vor, eine zu kaufen, da die bezahlbaren >= 2TB SSDs noch nicht in Sicht sind).

tatsächlich ist in meinem derzeitigen Setup der Klang-Unterschied zwischen Dateien-on-the-fly-falten und vorgefaltete Dateien abspielen so gering, dass ich kaum vorgefaltete Dateien habe. Und beim Dateien-on-the-fly-falten macht mein Skript genau, was Du vorschlägst: ich kopiere das zu spielende Album in eine RAM-Disk und hänge die Festplatte danach sogar aus (und nach dem Abspielen wieder ein).

Und wenn ich on-the-fly falte, dann kann ich beim besten Willen keinen Unterschied zwischen verschiedenen Dateien auf der Festplatte (oder auch anderen Medien) hören, ich habe es probiert.

USB-Stick ist mir zu lahm, zu klein und zu fummelig. Die "eingebaute Festplatte" (in meinem Odroid XU, über den ich hier im Forum schon berichtet habe) ist ein schneller 16 GB eMMC Speicher. Ich hatte auch mal vorgefaltete Dateien, die ich in meinem im Eingangsbeitrag beschriebenen Versuch angehört habe, darauf kopiert. Zu meiner Verwunderung fand ich den Klang "schlechter". (Ich hoffe, es ist klar, dass die Unterschiede, über die ich in diesem Thread berichtet habe, sehr subtil und nicht wie Tag und Nacht sind.)nihil.sine.causa hat geschrieben: Ich schlage vor, das auch mal mit einem USB Stick zu versuchen oder auch mal die eingebaute Festplatte zu verwenden.

(OT: Hm, vielleicht sollte ich doch mal eine SSD besorgen und probieren, ob die der Abspielvariante mit vorgefalteten Dateien wieder einen größeren Vorsprung geben kann? Falls jemand ein externes Gehäuse für SSD als USB-Festplatte kennt, das eine separate Stromversorgung hat, wäre ich für einen Hinweis dankbar.)

Ist das jetzt gut oder schlecht? Entweder entkoppelt etwas in dieser Kette das DAC Signal erfolgreich vom genutzten Medium, oder die Kette löst nicht genug auf, um die (subtilen) Unterschiede aufzuzeigen. Geh mal einfach von ersterem aus!nihil.sine.causa hat geschrieben: Ich kann den Effekt unterschiedlicher Medien übrigens bei meiner Kette nicht nachvollziehen. Entsprechende Tests habe ich vor einiger Zeit schon mal gemacht. Aber ich streame die Musikfiles ja auch ganz anders:

Festplatte (z.B. NAS) - Netzwerk - Linn-Streamer - Lautsprecher (Details in meinem Vorstellungsthread)

Viele Grüße,

Frank

-

axxxxx

Hallo Frank,

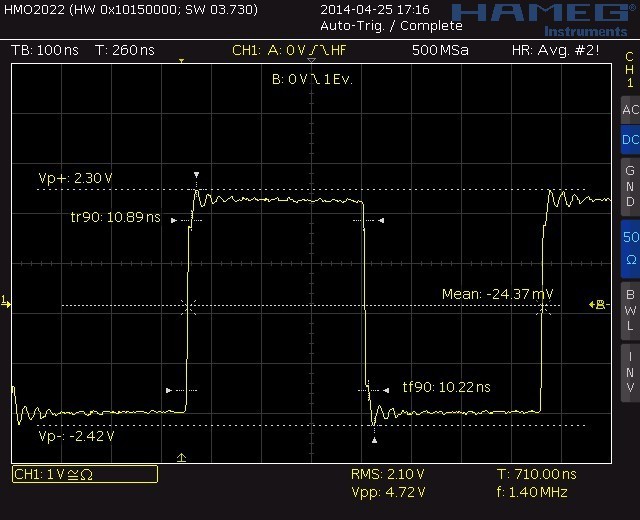

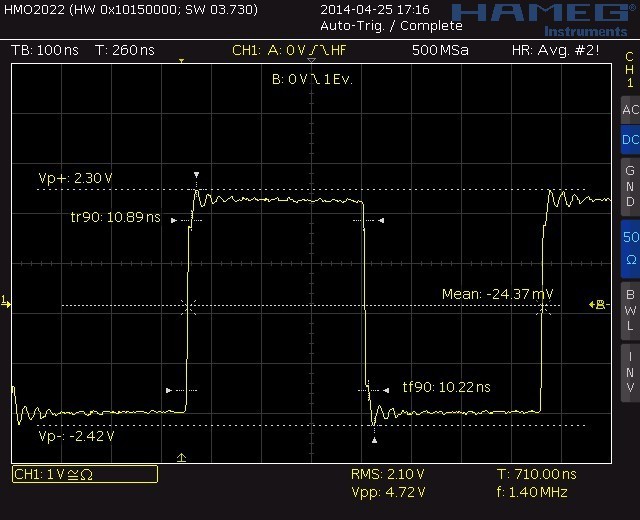

Dein erster Beitrag trifft es auf den Punkt. Vielen Dank für diese profunde Aufarbeitung dessen, was hier und anderswo zu diesem Thema diskutiert wurde. Das Bild unten zeigt das effektiv das am SPDIF Ausgang meines Teacs anliegende Signal:

Nicht ganz so schlimm, wie Dein Beispiel Nr. 4, aber immerhin.

Es wäre nun sehr interessant zu sehen, was daraus direkt am Eingang des DAC Chips geworden ist.

Gruß,

Kai

Dein erster Beitrag trifft es auf den Punkt. Vielen Dank für diese profunde Aufarbeitung dessen, was hier und anderswo zu diesem Thema diskutiert wurde. Das Bild unten zeigt das effektiv das am SPDIF Ausgang meines Teacs anliegende Signal:

Nicht ganz so schlimm, wie Dein Beispiel Nr. 4, aber immerhin.

Es wäre nun sehr interessant zu sehen, was daraus direkt am Eingang des DAC Chips geworden ist.

Gruß,

Kai

-

Hans-Martin

- Aktiver Hörer

- Beiträge: 9141

- Registriert: 14.06.2009, 15:45

Hallo Kai

4,7V zeigt, hier am SPDIF-Ausgang ist ohne Digitalkabel und ohne 75 Ohm Abschluss gemessen (war es das Digitalkabel mit Adapter am Hameg oder ein kompensierter Tastkopf mit 1 od.10MOhm?), ob Musik oder Stop, wird keinen Unterschied machen. Praxisnäher wäre es, hinter der Eingangsbuchse zu messen, im Vergleich zum Signal an der Ausgangsbuchse unter Last.

Viel interessanter fände ich eine solche Messung von Datenein- und -ausgang an der Festplatte im Schreib- und Lesebetrieb, auch vor und nach dem Cache. Da wüsste ich nicht, wo man anzapft ...

Grüße Hans-Martin

4,7V zeigt, hier am SPDIF-Ausgang ist ohne Digitalkabel und ohne 75 Ohm Abschluss gemessen (war es das Digitalkabel mit Adapter am Hameg oder ein kompensierter Tastkopf mit 1 od.10MOhm?), ob Musik oder Stop, wird keinen Unterschied machen. Praxisnäher wäre es, hinter der Eingangsbuchse zu messen, im Vergleich zum Signal an der Ausgangsbuchse unter Last.

Viel interessanter fände ich eine solche Messung von Datenein- und -ausgang an der Festplatte im Schreib- und Lesebetrieb, auch vor und nach dem Cache. Da wüsste ich nicht, wo man anzapft ...

Grüße Hans-Martin