Binaurales Kopfhörer-Hören

-

nihil.sine.causa

- Aktiver Hörer

- Beiträge: 1506

- Registriert: 28.07.2011, 12:31

- Wohnort: Bonn

-

nihil.sine.causa

- Aktiver Hörer

- Beiträge: 1506

- Registriert: 28.07.2011, 12:31

- Wohnort: Bonn

Hallo zusammen,

nochmals vielen Dank für Eure Antworten. Ich komme jetzt – wie versprochen – hier zurück mit meinem Erfahrungsbericht.

0. Vorbemerkung

Da ich keine Möglichkeit habe, meine Testergebnisse irgendwie zu objektivieren, beschreibe ich im Folgenden meine Höreindrücke. Ich bin mit meiner Kopfhörer Kette sehr zufrieden, was Klangfülle, Transparenz und Detailreichtum betrifft. Was ich verbessern will, ist das räumliche Hören, weil das Orchester mit meiner Kopfhörer-Kette eben in meinem Kopf lokalisiert ist. Und das klingt beim AUDEZE nach 100 Musikern im eigenen Kopf (und das ist etwas heftig auch wenn es sehr schön differenziert ist).

Noch eine Bemerkung zu existierenden Kunstkopfaufnahmen. Hier mal Beispiele:

http://kunstkopf-pod.podspot.de/

Für mich klingen solche Aufnahmen immer sehr interessant räumlich. Rechts-links gut zu orten und auch eine gewisse Tiefe. Allerdings orte ich die Schallquellen immer hinter mir, insbesondere hinter meinem Gesicht. Leider. (Diesen Effekt kann ich mit unterschiedlichen Kopfhörern reproduzieren.) Ich führe das darauf zurück, dass meine persönliche Kopf-Ohren-Geometrie und die daraus folgende kopfbezogener Übertragungsfunktion / head related transfer fuction (HRTF) eben nicht dem typischen Kunstkopf entspricht.

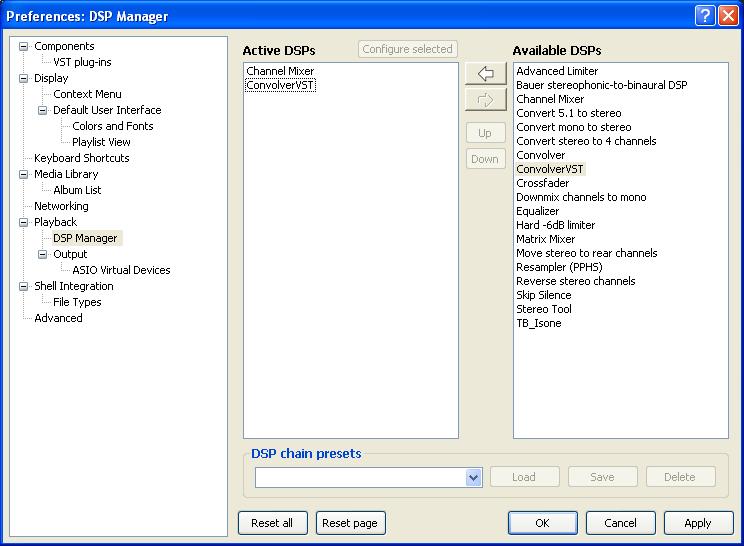

1. Foobar plugin Bauer stereophonic-to-binaural DSP

Tipps von Bernd Peter und Rudolf

Das Plugin habe ich unter

http://www.foobar2000.org/components

heruntergeladen und die dll im Foobar unter Components bekannt gemacht.

Wenn ich im DSP Manager das Plugin aktiviere, habe ich den folgenden Eindruck: Bei allen Vergleichsaufnahmen verliere ich schlagartig an Detailreichtum und Transparenz. Der Klang zieht sich gleichsam „zusammen“. Räumlich habe ich den Eindruck, die Musik sei stärker konzentriert auf eine Region kommt aber eindeutig immer noch aus meinem Kopf.

Der Vergleich der verschiedenen Einstellungen des „Crossfeed level“ liefert gewisse Unterschiede. Am wenigsten räumlich eingeschränkt erscheint mir die Einstellung nach J.Meier, aber seinen „Zweck“ erfüllt die Sache insgesamt nicht, der Gesamteindruck bleibt wie oben beschrieben.

2. Faltung geeigneter Pulsantworten

Tipps von Klaus und Uli

Die von Uli empfohlenen Beispielsounds

http://recherche.ircam.fr/equipes/salle ... ounds.html

habe ich durchgehört. Ich höre dabei das Testsignal räumlich wandern, allerdings immer hinter meinen Ohren. Die verschiedenen Anordnungen machen leider keinen großen Unterschied. Es hört sich schrecklich an, so als wäre mein Gesicht weggehämmert, wie bei einer alten, zerstörten Statue. Mir gibt das eben wieder ein Indiz, dass *meine* HRTF sich eben doch andersartig zu sein scheinen, als das, was gemeinhin als typisch angesehen werden mat. Ich habe mich dann für eines der Beispiele entschieden, aber – wie gesagt – nicht aufgrund detaillierter Differenzen. Meine Wahl ICR 1059.

Für meine „Aufstellung“ im virtuellen schalltoten Raum gehe ich von zwei Lautsprechern in dem berühmten gleichschenkligen Dreieck aus, also von einem Öffnungswinkel aus Sicht des Hörers von 60°. (Ich wäre lieber auf 70° gegangen, die azimutale 15° Rasterung der IRCAM Pulsantworten schränken aber etwas ein.)

Für den linken Pfad habe ich daher die Pulsantwort

IRC_1059_C_R0195_T150_P000.wav (-30° gegenüber T180)

und für den rechten Pfad

IRC_1059_C_R0195_T210_P000.wav (+30° gegenüber T180)

aus den IRCAM samples gewählt.

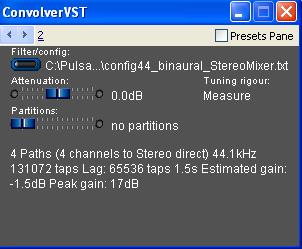

Zur Einrichtung des Convolver VST in Foobar2000. Dabei habe ich versucht, im Wesentlichen den Hinweisen von Christoph vom 09.05.2011 unter

http://www.aktives-hoeren.de/viewtopic. ... 7&start=15

zu folgen. Mit vereinten Kräften (danke an Uli, Vincent und Christoph!) ist es dann auch gelungen. Meine Konfiguration jetzt: Windows XP, foobar2000 1.1.7, VST adapter 0.9.0.3 (foo_vst_0903.zip), VST convolver4-4vc++

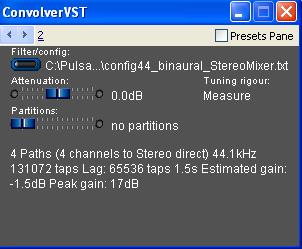

Nun noch die Konfiguration des Mischungsverhaltens der Pfade. Folgend den Hinweisen auf

http://convolver.sourceforge.net/configegs.html

zur Thematik “cross-talk cancellation / head-related transfer function (HRTF) network”, bei der eine lineare Überlagerung des rechten und linken Stereo-Signals realisiert wird. Da die oben ausgewählten Pulsantworten die HRTF kompensierten Stereosignale produzieren müssten, ist eben „lediglich“ das Übersprechverhalten zu eliminieren. [Ich hoffe, ich habe das so richtig verstanden.]. Die resultierende config-Datei für den ConvolverVST sieht daher bei mir wie folgt aus:

44100 2 2 0

0 0

0 0

C:\Pulsantworten\IRC_1059_C_R0195_T150_P000.wav

0

0.0

0.0

C:\Pulsantworten\IRC_1059_C_R0195_T150_P000.wav

1

0.0

1.0

C:\Pulsantworten\IRC_1059_C_R0195_T210_P000.wav

0

1.0

0.0

C:\Pulsantworten\IRC_1059_C_R0195_T210_P000.wav

1

1.0

1.0

Nun zum Hörgergebnis: Es ergibt sich mit der so erzeugten Korrektur ein realistischerer räumlicher Eindruck beim unkorrigierten Signal. Allerdings ist dabei räumlich immer noch alles „verschränkt“ und ich lokalisiere es – wie zu befürchten war – wieder hinter meinem Gesicht. Darüber hinaus verliere ich durch die Umrechnerei offenbar Details und Transparenz. Hinzu kommt, dass die IRCAM Pulsantworten allesamt mit 44,1 kHz gesampelt sind und ich damit auch nicht auf solidem Weg über 44,1 kHz hinauskomme.

Fazit: Sehr interessanter Test und beste räumliche Differenzierung im Vergleich zu den anderen Tests. Wenn ich nur meine eigene HRTF messen könnte, käme vielleicht auch mal ein Höreindruck vor meinem Gesicht heraus. Dennoch bilde ich mir ein, bei verschiedenen Aufnahmen unterschiedliche räumliche Konstellationen zu hören, die ich dem reinen Stereo-Signal nicht entnehmen kann. Einem meiner Ziele bin ich damit näher gekommen.

3. Tone Boosters Isone

Tipp von Vincent

Die Demo-Version

http://www.toneboosters.com/tb-isone/

ließ sich als VST plug-in auf Basis des oben erwähnten VST Adapters leicht installieren. Die Stärke liegt in der Simulation verschiedener Räume (so ist z.B. auch ein sehr trockener Abhörraum verfügbar). Darüber hinaus gibt es verschiedene vordefinierte crossfeed-Einstellungen. Der Höreindruck der verschiedenen Räume ist recht interessant, aber zielt eben nicht auf mein ursprüngliches Ziel ab, den ursprünglichen Aufnahmeraum herauszuschälen.

Der eingebaute sog. HRTF designer (mit drei Drehreglern für die Parameter HRTF Stärke, Ohrengröße und Kopfgröße) ist dagegen aus meiner Sicht eher eine Spielerei. Auch hier habe ich das Phänomen, dass der räumliche Eindruck sich auf den Bereich hinter mir be-/verschränkt.

Vorteilhaft ist, dass keine Einschränkungen hinsichtlich Samplingrate (zumindest bis 192 kHz) zu existieren scheinen und auch der Verlust an Transparenz und Detailreichtum hält sich nach meinem Geschmack noch in Grenzen.

4. Hinweise zu den anderen Tipps:

Die Hinweise von Jörn:

Das Beyerdynamic Headzone System wäre sicher mal interessant zu hören. Mein Ziel aber war und ist die Manipulation hin zum räumlichen Hören auf digitaler Ebene vorzunehmen.

Analoges gilt für die Lösung von emt-Studiotechnik, die allerdings auch nicht lieferbar zu sein scheint.

Der Hinweis von Rainer zum Smyth Realiser A8 ist ebenfalls interessant. Hierbei geht es vor allem darum die optimierte Abhörsituation mit Kopfhörern nachzuempfinden (wenn etwa die großen Schallwandler während der Nachtruhe stumm bleiben müssen). Beim Realiser wird eine Raumimplusantwort in Verbindung mit der HRTF in *einer* Datei abgespeichert. Das hilft mir leider nichts, da ich ja eben keine Lautsprecher habe, an denen ich mich orientieren könnte und es widerspricht eben auch meinem Designprinzip, die Korrektur auf digitaler Ebene vor der Wandlung vornehmen zu wollen. Analoges gilt für den Tipp von Vincent zum HeaDSPeaker Home.

Rudolf weist auf eine interessante Diskussion zum Thema Auralisation hin. Ich kann mir vorstellen, dass ich mein Problem mit Hilfe der Software Odeon Room Acoustics lösen kann. Ich habe mir die Testversion dieser Software angesehen. Mit ihr lassen sich Räume designen und die daraus resultierenden Pulsanworten ableiten. Das Thema HRTF wird wiederum eher am Rande behandelt. Was ich ja aber simulieren möchte, ist eine (Monitoring-)Abhörsituation, die die Charakteristika des ursprünglichen Aufnahmeraums herausschälen sollte, dessen Eigenschaften mir typischerweise unbekannt sind. Odeon ist m.E. in erster Linie für Architekten und Raumakustiker gemacht, die eben neue Räume kreieren oder bestehende akustisch verbessern wollen.

5. Fazit:

Interessante Schritte, um dem o.g. Ziel ein wenig näher zu kommen. Bitter ist für mich, dass die Räumlichkeit des Klanggeschehens immer hinter meinem Gesichtsfeld bleibt. Ich hoffe, eine Messung „meiner“ HRTF würde hier Abhilfe schaffen und den Raum schließlich nach vorne öffnen. Und nach wie vor suche ich hierfür ein Messverfahren / Set.

Gruß

Harald

nochmals vielen Dank für Eure Antworten. Ich komme jetzt – wie versprochen – hier zurück mit meinem Erfahrungsbericht.

0. Vorbemerkung

Da ich keine Möglichkeit habe, meine Testergebnisse irgendwie zu objektivieren, beschreibe ich im Folgenden meine Höreindrücke. Ich bin mit meiner Kopfhörer Kette sehr zufrieden, was Klangfülle, Transparenz und Detailreichtum betrifft. Was ich verbessern will, ist das räumliche Hören, weil das Orchester mit meiner Kopfhörer-Kette eben in meinem Kopf lokalisiert ist. Und das klingt beim AUDEZE nach 100 Musikern im eigenen Kopf (und das ist etwas heftig auch wenn es sehr schön differenziert ist).

Noch eine Bemerkung zu existierenden Kunstkopfaufnahmen. Hier mal Beispiele:

http://kunstkopf-pod.podspot.de/

Für mich klingen solche Aufnahmen immer sehr interessant räumlich. Rechts-links gut zu orten und auch eine gewisse Tiefe. Allerdings orte ich die Schallquellen immer hinter mir, insbesondere hinter meinem Gesicht. Leider. (Diesen Effekt kann ich mit unterschiedlichen Kopfhörern reproduzieren.) Ich führe das darauf zurück, dass meine persönliche Kopf-Ohren-Geometrie und die daraus folgende kopfbezogener Übertragungsfunktion / head related transfer fuction (HRTF) eben nicht dem typischen Kunstkopf entspricht.

1. Foobar plugin Bauer stereophonic-to-binaural DSP

Tipps von Bernd Peter und Rudolf

Das Plugin habe ich unter

http://www.foobar2000.org/components

heruntergeladen und die dll im Foobar unter Components bekannt gemacht.

Wenn ich im DSP Manager das Plugin aktiviere, habe ich den folgenden Eindruck: Bei allen Vergleichsaufnahmen verliere ich schlagartig an Detailreichtum und Transparenz. Der Klang zieht sich gleichsam „zusammen“. Räumlich habe ich den Eindruck, die Musik sei stärker konzentriert auf eine Region kommt aber eindeutig immer noch aus meinem Kopf.

Der Vergleich der verschiedenen Einstellungen des „Crossfeed level“ liefert gewisse Unterschiede. Am wenigsten räumlich eingeschränkt erscheint mir die Einstellung nach J.Meier, aber seinen „Zweck“ erfüllt die Sache insgesamt nicht, der Gesamteindruck bleibt wie oben beschrieben.

2. Faltung geeigneter Pulsantworten

Tipps von Klaus und Uli

Die von Uli empfohlenen Beispielsounds

http://recherche.ircam.fr/equipes/salle ... ounds.html

habe ich durchgehört. Ich höre dabei das Testsignal räumlich wandern, allerdings immer hinter meinen Ohren. Die verschiedenen Anordnungen machen leider keinen großen Unterschied. Es hört sich schrecklich an, so als wäre mein Gesicht weggehämmert, wie bei einer alten, zerstörten Statue. Mir gibt das eben wieder ein Indiz, dass *meine* HRTF sich eben doch andersartig zu sein scheinen, als das, was gemeinhin als typisch angesehen werden mat. Ich habe mich dann für eines der Beispiele entschieden, aber – wie gesagt – nicht aufgrund detaillierter Differenzen. Meine Wahl ICR 1059.

Für meine „Aufstellung“ im virtuellen schalltoten Raum gehe ich von zwei Lautsprechern in dem berühmten gleichschenkligen Dreieck aus, also von einem Öffnungswinkel aus Sicht des Hörers von 60°. (Ich wäre lieber auf 70° gegangen, die azimutale 15° Rasterung der IRCAM Pulsantworten schränken aber etwas ein.)

Für den linken Pfad habe ich daher die Pulsantwort

IRC_1059_C_R0195_T150_P000.wav (-30° gegenüber T180)

und für den rechten Pfad

IRC_1059_C_R0195_T210_P000.wav (+30° gegenüber T180)

aus den IRCAM samples gewählt.

Zur Einrichtung des Convolver VST in Foobar2000. Dabei habe ich versucht, im Wesentlichen den Hinweisen von Christoph vom 09.05.2011 unter

http://www.aktives-hoeren.de/viewtopic. ... 7&start=15

zu folgen. Mit vereinten Kräften (danke an Uli, Vincent und Christoph!) ist es dann auch gelungen. Meine Konfiguration jetzt: Windows XP, foobar2000 1.1.7, VST adapter 0.9.0.3 (foo_vst_0903.zip), VST convolver4-4vc++

Nun noch die Konfiguration des Mischungsverhaltens der Pfade. Folgend den Hinweisen auf

http://convolver.sourceforge.net/configegs.html

zur Thematik “cross-talk cancellation / head-related transfer function (HRTF) network”, bei der eine lineare Überlagerung des rechten und linken Stereo-Signals realisiert wird. Da die oben ausgewählten Pulsantworten die HRTF kompensierten Stereosignale produzieren müssten, ist eben „lediglich“ das Übersprechverhalten zu eliminieren. [Ich hoffe, ich habe das so richtig verstanden.]. Die resultierende config-Datei für den ConvolverVST sieht daher bei mir wie folgt aus:

44100 2 2 0

0 0

0 0

C:\Pulsantworten\IRC_1059_C_R0195_T150_P000.wav

0

0.0

0.0

C:\Pulsantworten\IRC_1059_C_R0195_T150_P000.wav

1

0.0

1.0

C:\Pulsantworten\IRC_1059_C_R0195_T210_P000.wav

0

1.0

0.0

C:\Pulsantworten\IRC_1059_C_R0195_T210_P000.wav

1

1.0

1.0

Nun zum Hörgergebnis: Es ergibt sich mit der so erzeugten Korrektur ein realistischerer räumlicher Eindruck beim unkorrigierten Signal. Allerdings ist dabei räumlich immer noch alles „verschränkt“ und ich lokalisiere es – wie zu befürchten war – wieder hinter meinem Gesicht. Darüber hinaus verliere ich durch die Umrechnerei offenbar Details und Transparenz. Hinzu kommt, dass die IRCAM Pulsantworten allesamt mit 44,1 kHz gesampelt sind und ich damit auch nicht auf solidem Weg über 44,1 kHz hinauskomme.

Fazit: Sehr interessanter Test und beste räumliche Differenzierung im Vergleich zu den anderen Tests. Wenn ich nur meine eigene HRTF messen könnte, käme vielleicht auch mal ein Höreindruck vor meinem Gesicht heraus. Dennoch bilde ich mir ein, bei verschiedenen Aufnahmen unterschiedliche räumliche Konstellationen zu hören, die ich dem reinen Stereo-Signal nicht entnehmen kann. Einem meiner Ziele bin ich damit näher gekommen.

3. Tone Boosters Isone

Tipp von Vincent

Die Demo-Version

http://www.toneboosters.com/tb-isone/

ließ sich als VST plug-in auf Basis des oben erwähnten VST Adapters leicht installieren. Die Stärke liegt in der Simulation verschiedener Räume (so ist z.B. auch ein sehr trockener Abhörraum verfügbar). Darüber hinaus gibt es verschiedene vordefinierte crossfeed-Einstellungen. Der Höreindruck der verschiedenen Räume ist recht interessant, aber zielt eben nicht auf mein ursprüngliches Ziel ab, den ursprünglichen Aufnahmeraum herauszuschälen.

Der eingebaute sog. HRTF designer (mit drei Drehreglern für die Parameter HRTF Stärke, Ohrengröße und Kopfgröße) ist dagegen aus meiner Sicht eher eine Spielerei. Auch hier habe ich das Phänomen, dass der räumliche Eindruck sich auf den Bereich hinter mir be-/verschränkt.

Vorteilhaft ist, dass keine Einschränkungen hinsichtlich Samplingrate (zumindest bis 192 kHz) zu existieren scheinen und auch der Verlust an Transparenz und Detailreichtum hält sich nach meinem Geschmack noch in Grenzen.

4. Hinweise zu den anderen Tipps:

Die Hinweise von Jörn:

Das Beyerdynamic Headzone System wäre sicher mal interessant zu hören. Mein Ziel aber war und ist die Manipulation hin zum räumlichen Hören auf digitaler Ebene vorzunehmen.

Analoges gilt für die Lösung von emt-Studiotechnik, die allerdings auch nicht lieferbar zu sein scheint.

Der Hinweis von Rainer zum Smyth Realiser A8 ist ebenfalls interessant. Hierbei geht es vor allem darum die optimierte Abhörsituation mit Kopfhörern nachzuempfinden (wenn etwa die großen Schallwandler während der Nachtruhe stumm bleiben müssen). Beim Realiser wird eine Raumimplusantwort in Verbindung mit der HRTF in *einer* Datei abgespeichert. Das hilft mir leider nichts, da ich ja eben keine Lautsprecher habe, an denen ich mich orientieren könnte und es widerspricht eben auch meinem Designprinzip, die Korrektur auf digitaler Ebene vor der Wandlung vornehmen zu wollen. Analoges gilt für den Tipp von Vincent zum HeaDSPeaker Home.

Rudolf weist auf eine interessante Diskussion zum Thema Auralisation hin. Ich kann mir vorstellen, dass ich mein Problem mit Hilfe der Software Odeon Room Acoustics lösen kann. Ich habe mir die Testversion dieser Software angesehen. Mit ihr lassen sich Räume designen und die daraus resultierenden Pulsanworten ableiten. Das Thema HRTF wird wiederum eher am Rande behandelt. Was ich ja aber simulieren möchte, ist eine (Monitoring-)Abhörsituation, die die Charakteristika des ursprünglichen Aufnahmeraums herausschälen sollte, dessen Eigenschaften mir typischerweise unbekannt sind. Odeon ist m.E. in erster Linie für Architekten und Raumakustiker gemacht, die eben neue Räume kreieren oder bestehende akustisch verbessern wollen.

5. Fazit:

Interessante Schritte, um dem o.g. Ziel ein wenig näher zu kommen. Bitter ist für mich, dass die Räumlichkeit des Klanggeschehens immer hinter meinem Gesichtsfeld bleibt. Ich hoffe, eine Messung „meiner“ HRTF würde hier Abhilfe schaffen und den Raum schließlich nach vorne öffnen. Und nach wie vor suche ich hierfür ein Messverfahren / Set.

Gruß

Harald

-

uli.brueggemann

- Aktiver Hersteller

- Beiträge: 4659

- Registriert: 23.03.2009, 15:58

- Wohnort: 33649

- Kontaktdaten:

Harald,nihil.sine.causa hat geschrieben: Und nach wie vor suche ich hierfür ein Messverfahren / Set.

vielleicht hilft http://www.soundman.de

und dazu auch noch http://iaem.at/kurse/winter-08-09/aac02 ... nload/file

Grüsse, Uli

-

nihil.sine.causa

- Aktiver Hörer

- Beiträge: 1506

- Registriert: 28.07.2011, 12:31

- Wohnort: Bonn

-

vincent kars

- Aktiver Hörer

- Beiträge: 154

- Registriert: 15.03.2011, 16:50

- Kontaktdaten:

-

nihil.sine.causa

- Aktiver Hörer

- Beiträge: 1506

- Registriert: 28.07.2011, 12:31

- Wohnort: Bonn

Die Ohren lassen sich doch überlisten

Will Euch mal auf dem Laufenden halten, was ich in Sachen binaurales Kopfhörer-Hören so unternommen habe. Bevor ich in die vorgeschlagenen Tools und in die Falterei tiefer eingestiegen bin, habe ich mir nochmals grundsätzlich die Frage gestellt: Ist es möglich, meinen Ohren zu suggerieren, der Schall käme nicht aus meinem Kopf, obwohl ich einen Kopfhörer benutze?

Angeregt von Ulis Vorschlag ...

Roland bietet für einen sehr überschaubaren Betrag (89,- bei thomann) Mikrofone an, die man in die Ohren stecken kann.

http://www.roland.com/products/en/CS-10EM/index.html

Die Dinger sind nicht besonders flach gebaut. Idealerweise müsste das Mic möglichst tiefer in den Gehörgang. Aber es ist ja nur Spielzeug. Es gibt übrigens auch noch weitere Alternativen zu den Soundman, die Uli vorgeschlagen hat: auf der nach oben offenen Preisskala:

http://www.bksv.com/Products/Transducer ... /4101.aspx

Also die Roland CD-10EM. Jetzt brauchen die aber eine Vorspannung von 2-10V bei 3,5mm Steckern. Bevor ich da lange rum gemacht habe, habe ich kurzerhand noch ein Spielzeug, den Zoom H2 bestellt, der die Vorspannung liefert.

http://www.zoom.co.jp/english/products/h2/

Ergebnis: Wenn ich meine "Aufnahmen" über Kopfhörer abspiele (immerhin 96/24 wav) höre ich in der Tat und zum ersten Mal die Schallquelle vor mir und räumlich. Es geht also. Die Frage von oben ist eindeutig mit "ja" beantwortet. Und es "hängt" wirklich an meinen Ohren, andere Test-Hörer empfinden die Aufnahmen zwar räumlich aber keineswegs eindeutig von vorne kommend.

Das macht mir Hoffnung, meine kleinen Experimente weiterzuführen und mich der kopfbezogenen Übertragungsfunktion / head related transfer fuction (HRTF) weiter zu nähern.

Gruß

Harald

Angeregt von Ulis Vorschlag ...

... habe ich das folgende Setup gewählt. Ich nenne es mal "Spielzeug":uli.brueggemann hat geschrieben:Harald,

vielleicht hilft http://www.soundman.de

und dazu auch noch http://iaem.at/kurse/winter-08-09/aac02 ... nload/file

Roland bietet für einen sehr überschaubaren Betrag (89,- bei thomann) Mikrofone an, die man in die Ohren stecken kann.

http://www.roland.com/products/en/CS-10EM/index.html

Die Dinger sind nicht besonders flach gebaut. Idealerweise müsste das Mic möglichst tiefer in den Gehörgang. Aber es ist ja nur Spielzeug. Es gibt übrigens auch noch weitere Alternativen zu den Soundman, die Uli vorgeschlagen hat: auf der nach oben offenen Preisskala:

http://www.bksv.com/Products/Transducer ... /4101.aspx

Also die Roland CD-10EM. Jetzt brauchen die aber eine Vorspannung von 2-10V bei 3,5mm Steckern. Bevor ich da lange rum gemacht habe, habe ich kurzerhand noch ein Spielzeug, den Zoom H2 bestellt, der die Vorspannung liefert.

http://www.zoom.co.jp/english/products/h2/

Ergebnis: Wenn ich meine "Aufnahmen" über Kopfhörer abspiele (immerhin 96/24 wav) höre ich in der Tat und zum ersten Mal die Schallquelle vor mir und räumlich. Es geht also. Die Frage von oben ist eindeutig mit "ja" beantwortet. Und es "hängt" wirklich an meinen Ohren, andere Test-Hörer empfinden die Aufnahmen zwar räumlich aber keineswegs eindeutig von vorne kommend.

Das macht mir Hoffnung, meine kleinen Experimente weiterzuführen und mich der kopfbezogenen Übertragungsfunktion / head related transfer fuction (HRTF) weiter zu nähern.

Gruß

Harald

Hallo Harald,

Du hast völlig recht:

Erst mit der beschriebenen Lösung habe ich das Problem überwunden, das Du so beschrieben hast:

Schade, dass die damaligen Ansätze nicht wirklich konsequent weiter verfolgt werden, wo doch heute über die erheblich größere Prozessorleistung noch mehr und dies obendrein auch kostengünstiger zu realisieren wäre. Gleichzeitig wundere ich mich, was sich auch anspruchsvolle KH-Nutzer zumuten! Der beste, weil kritischste Test ist und bleibt, wie lange man entspannt und intensiv zugleich über seinen (hochwertigen) KH hören kann.

* Begleitheft zur Test-CD (PDF)

Gruß

Joe

Du hast völlig recht:

Ich habe so was machen lassen. Das gab es mal als Angebot bei AKG in Wien und München. Hier mache ich es kurz und verweise auf meine ausführliche Schilderung (obwohl da ein kleiner Fehler drin steckt, wie ich beim Überfliegen bemerkt habe, der aber nichts zur Sache tut).nihil.sine.causa hat geschrieben:Idealerweise müsste das Mic möglichst tiefer in den Gehörgang.

Erst mit der beschriebenen Lösung habe ich das Problem überwunden, das Du so beschrieben hast:

Leider ist mir keine aktuelle wirklich konsequente Lösung bekannt. Es hilft ja nur teilweise, sich den von mir genannten KH-Prozessor zu besorgen - so man überhaupt noch einen findet. Und einfach Probe zu hören, ob für Dich eines der 9 Presets* genau genug passt, wird heutzutage vermutlich auch nicht mehr zu realisieren sein.nihil.sine.causa hat geschrieben:Das intensive Hören mit dem Kopfhörer ist ... auf Dauer nicht auszuhalten. Es ist als würde man nur Buttercreme essen. So lecker das zunächst ist, es wird dann zuviel. 100 Musiker im eigenen Kopf, das halte ich auf Dauer nicht aus. Mein Versuch, eine binaurale Korrektur vorzunehmen ist bislang leider noch nicht geglückt, trotz vieler kompetenter und interessanter Tipps hier aus dem Forum und vieler spannender Kopf-Experimente an meinem Hörplatz.

Schade, dass die damaligen Ansätze nicht wirklich konsequent weiter verfolgt werden, wo doch heute über die erheblich größere Prozessorleistung noch mehr und dies obendrein auch kostengünstiger zu realisieren wäre. Gleichzeitig wundere ich mich, was sich auch anspruchsvolle KH-Nutzer zumuten! Der beste, weil kritischste Test ist und bleibt, wie lange man entspannt und intensiv zugleich über seinen (hochwertigen) KH hören kann.

* Begleitheft zur Test-CD (PDF)

Gruß

Joe

-

nihil.sine.causa

- Aktiver Hörer

- Beiträge: 1506

- Registriert: 28.07.2011, 12:31

- Wohnort: Bonn

FIR Filter zur Vermeidung von In-Kopf-Lokalisation beim Kopfhörer-Hören?

Liebe Forenten,

nun bin ich wieder einen Schritt weiter: Durch Einsatz von FIR Filter kann ich die in-Kopf-Lokalisation beim Kopfhörer-Hören vermeiden. Was jetzt folgt ist allerdings noch sehr im Versuchststadium. Uli Brüggemann, dem ich die Methode vorab dargestellt habe, hat schon angedeutet, dass der Korrekturfilteransatz falsch ist. Aber der Reihe nach.

Ich verwende im Folgenden wieder die Methode, ein Kochrezept darzustellen. Wie das dann realiter schmeckt, findet man sicher erst beim "Nachkochen" heraus. Vielleicht kommen Euch beim Lesen aber auch Ideen, ohne dass Ihr es explizit nachvollziet. Jedes Feed-back kann hilfreich sein. Und alles eben noch im Versuchsstadium ist, bin ich sehr, sehr daran interessiert, welche Ideen Ihr dazu habt.

Wer von Euch an dieser Fragestellung tieferes Interesse hat, kann sich auch gerne per PN bei mir melden. Meine gesamte Ausrüstung, die ich zum Messen und Abhören benötige, passt durchaus in eine Klappbox (wenn ich die LS mal ausklammere)...

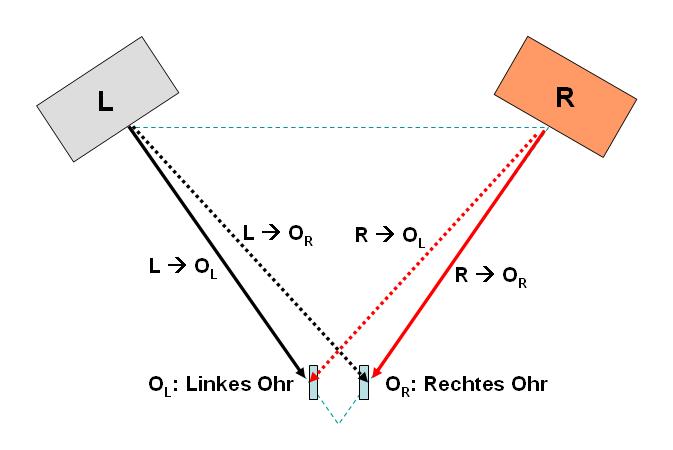

1. Grundbegriffe und Vorgehensweise

Grundsättzlich bin ich mit meiner Kopfhörer Kette sehr zufrieden, was Klangfülle, Transparenz und Detailreichtum betrifft. Was ich verbessern will, ist das räumliche Hören, weil das Orchester mit meiner Kopfhörer-Kette eben in meinem Kopf lokalisiert zu sein scheint. Und das klingt beim AUDEZE nach 100 Musikern im eigenen Kopf (und das ist etwas heftig auch wenn es sehr schön differenziert ist).

Ideen hierzu wurden in diesem Thread ausgetauscht:

http://www.aktives-hoeren.de/viewtopic. ... 7&start=15

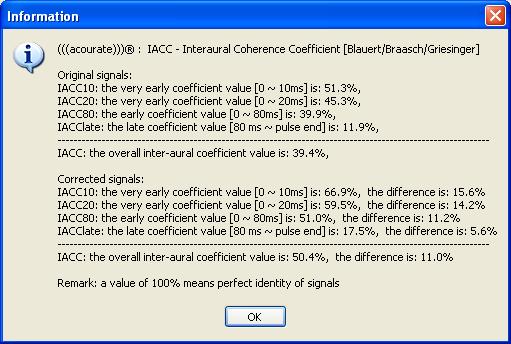

Nun folgt der Versuch, meine individuelle „Head Related Transfer Function“ (HRTF) zu messen und durch geeignete FIR Filter beim Abspielen zu berücksichtigen. Dies sollte die „In-Kopf-Lokalisation“ (IKL) vermeiden und zu einem räumlicheren Höreindruck beim Kopf-Hören führen.

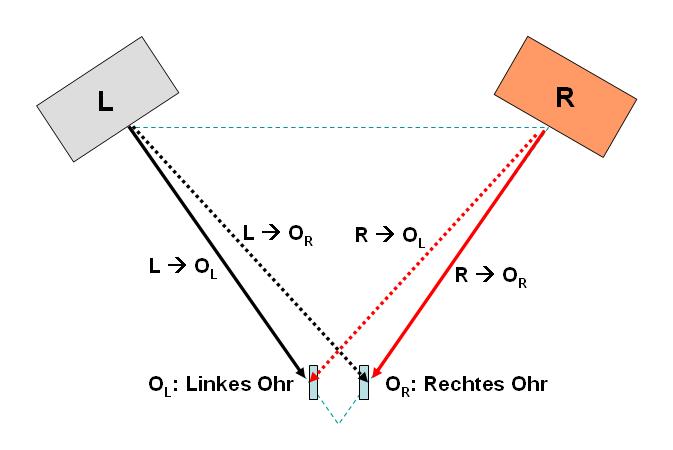

Gehen wir dazu mal idealisiert von einer möglichst raum-neutralen Stereo-Abhörsituation mit zwei Lautsprechern aus. Mit dem linken Ohr OL hören wir dann nicht nur das aus dem linken Kanal L stammende Signal „L --> OL“ sondern auch – leicht zeitversetzt und entsprechend durch unsere Anatomie verfremdet – das aus dem rechten Kanal R stammende “R --> OL“. Die HRTF (vgl. etwa http://de.wikipedia.org/wiki/HRTF) charakterisiert also eine Filterwirkung von Kopf, Außenohr, Rumpf etc.

Die Idee ist nun, die HRTF unter Verwendung einer Stereo-Abhörkette zu messen und entsprechende FIR Filter zu generieren, mit denen beim Abspielen die Stereo-Signale dann geeignet gefaltet werden.

Was die zeitliche Verzögerung der Pfade “L --> OR“ und “R --> OL“ betrifft, habe ich auf Basis meines Ohrabstandes und elementaren geometrischen Überlegungen einen Wert von 0,233 ms errechnet und ganz gute Erfahrungen gemacht mit 0,22 ms.

2. Messverfahren

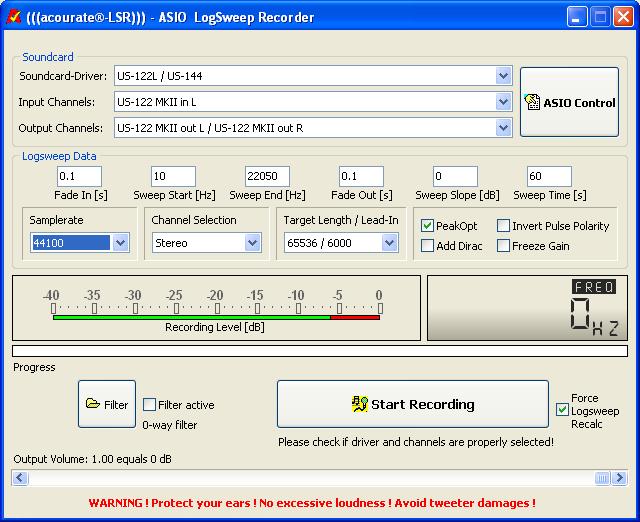

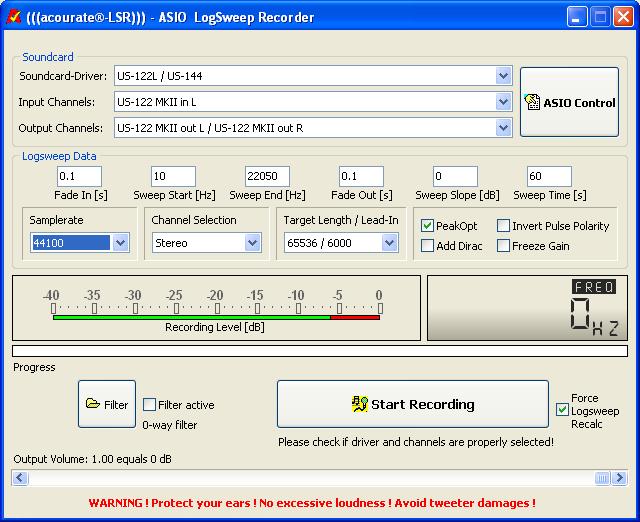

Ich verwende eine Messaufbau wie folgt.

Dazu wurde ich angeregt durch den Aufbau eines älteren Sennheiser Kopfbügelmikrofons MKE 2002:

http://www.sennheiser.com/sennheiser/ol ... 90_Sp3.pdf

Bei der Messung von LogSweeps halte ich das Behringer Messmikro von Hand so, dass der vom jeweiligen Ohr reflektierte Schall gemessen wird, ganz analog zu den Zeichnungen in der Anleitung zum Sennheiser MKE 2002.

Ich benötige für die vier oben skizzierten Pfade zwei Stero-LogSweeps. Ich beschreibe das Verfahren jetzt für das linke Ohr. Für das rechte Ohr geht dann alles analog. Betrachten wir also zunächst den Stereo-Logsweep für das linke Ohr OL. D.h. während der gesamten Messung wird das Mikro ans linke Ohr gehalten. Zuerst kommt das LogSweep Signal aus dem linken und dann aus dem rechten Kanal.

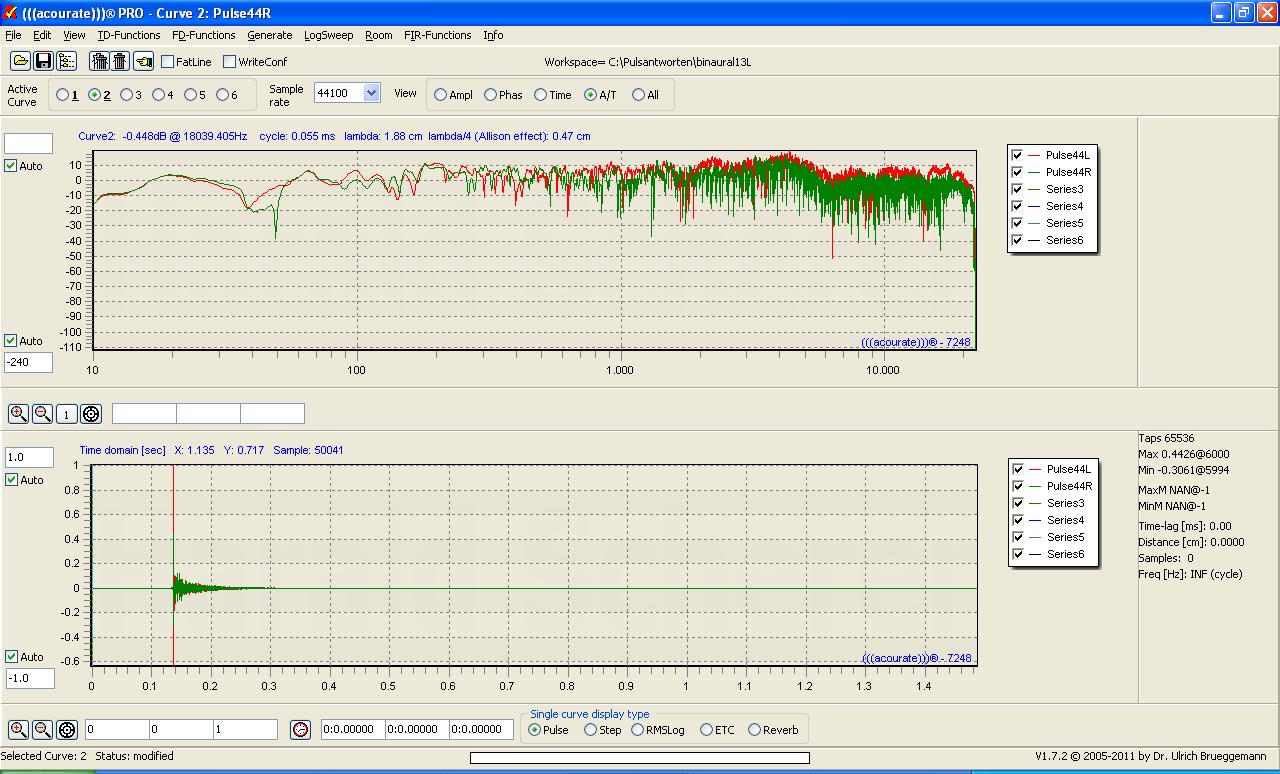

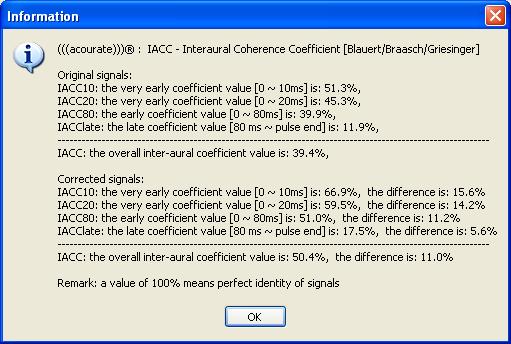

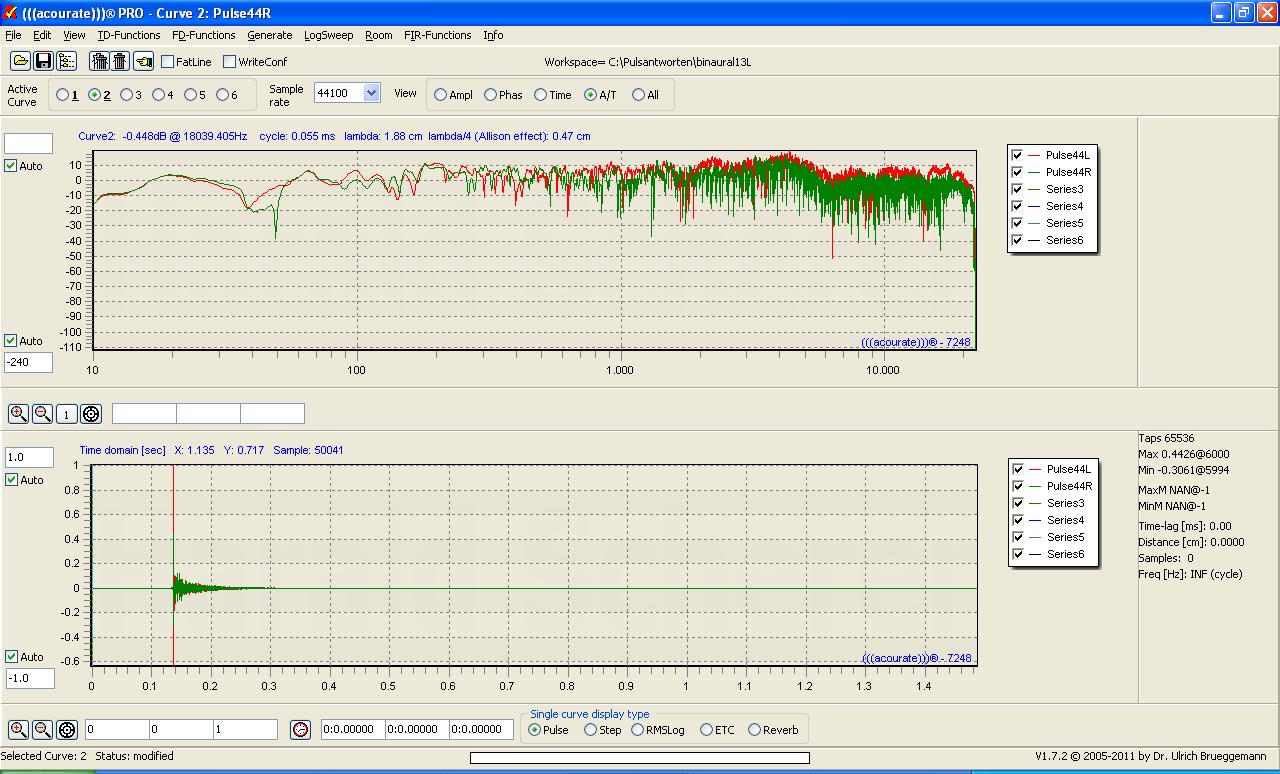

Im Resultat repräsentiert Pulse44L den Pfad „L --> OL“ (rote Kurve) und Pulse44R den Pfad „R --> OL“ (die grüne Kurve logischerweise mit geringerem Pegel).

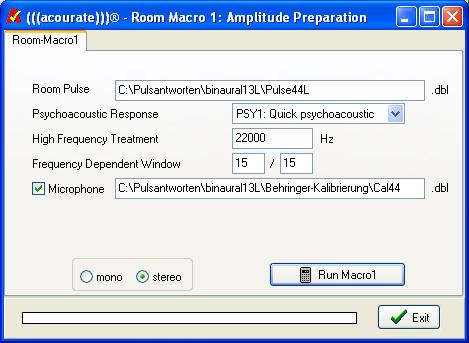

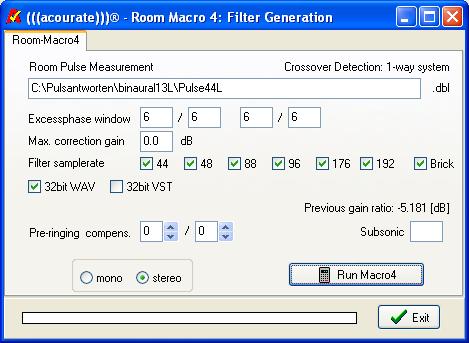

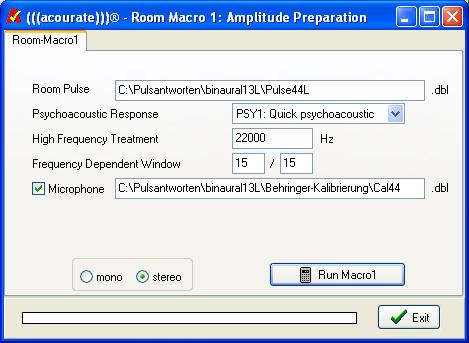

Nun kenne ich mit (((acourate))) nicht sehr gut aus. Ich verwende daher auch für meinen Zweck die Room-Macros, auch wenn sie sicher für einen anderen Zweck entwickelt wurden. Gerade hier hoffe ich auf Tipps von den (((acourate))) Experten unter Euch.

Resultat von Room Macro 1 sind geglättete Pulsefunktionen.

Nun verwende ich die Macros 2 (Target Curve Design) und 3 (Inversion) nicht, da ich ja die spezifischen Eigenschaften der Pulsefunktionen nicht korrigieren sondern eben für die FIR Filter verwenden will. Ich behelfe mir daher damit, die Ergebnisse aus Macro 1 umzukopieren.

Pulse44Lmp.dbl --> Pulse44Linv.dbl und

Pulse44Rmp.dbl --> Pulse44Rinv.dbl

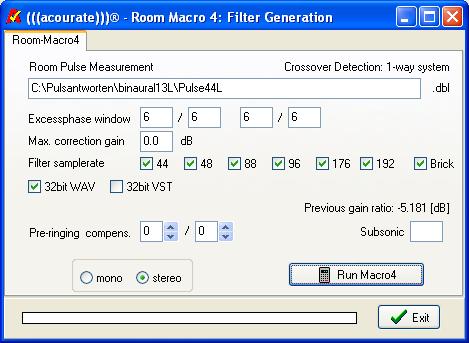

und tue so, als hätte Macro 3 ein entsprechendes Ergebnis geliefert. Anschließend wende ich Macro 4 (Filter Generation) an, um die FIR Filter zu generieren.

Die resultierenden Filter repräsentieren dann die Pfade für das linke Ohr OL. Damit ich sie später unterscheiden kann von denjenigen fürs rechte Ohr, kopiere ich sie ebenfalls um, also z.B. Cor1S44.wav --> Cor1LS44.wav

Der Vollständigkeit halber liefert Macro 5 (Test Convolution) folgendes Resultat:

Dieselbe Prozedur für rechte Ohr OR (also neues Projekt, ebenfalls Stereo-LogSweep, Glätten, Filter bestimmen) liefert die Filter fürs rechte Ohr, welche ich entsprechend umbenenne, z.B. Cor1S44.wav --> Cor1RS44.wav.

3. Wiedergabe

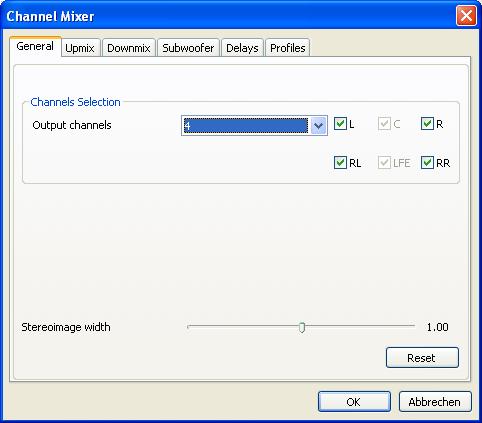

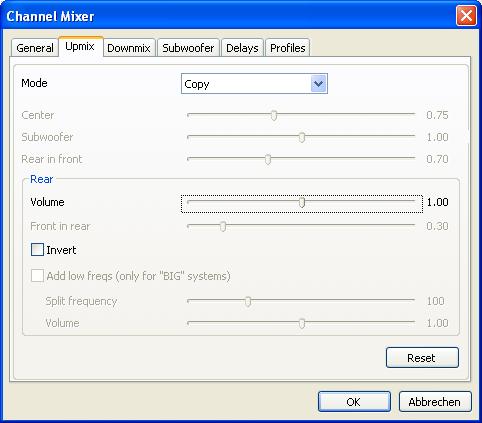

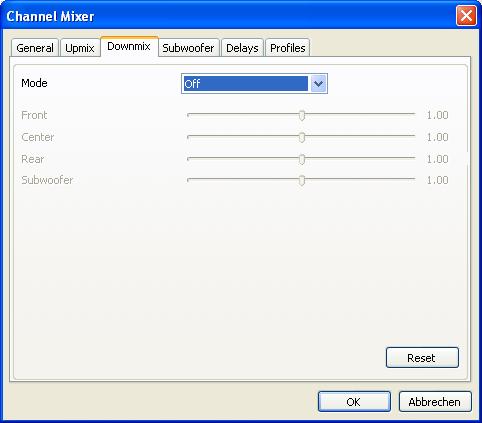

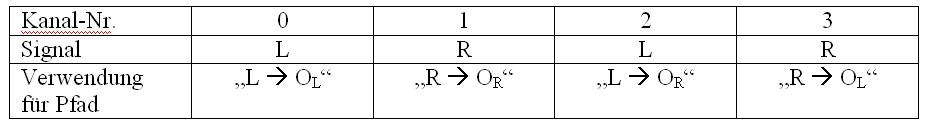

Für die Wiedergabe verwende ich den ConvolverVST. Die Pfade „L --> OL“ und „R --> OR“ könnten wie normale Stereo-FIR verwendet werden. Für die Pfade „R --> OL“ und „L --> OR“ dagegen benötige ich eine leichte zeitliche Verzögerung. Denn das entfernter liegende Ohr bekommt das Signal ja später. Um das dem Convolver VST beizubringen, verwende ich das foobar plugin „Channel Mixer“ und generiere damit aus dem Stereo-Signal ein Vier-Kanal-Signal.

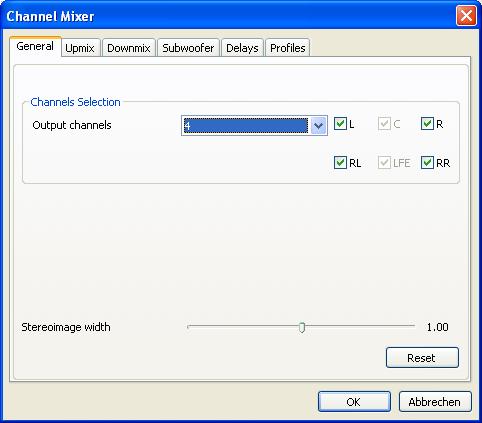

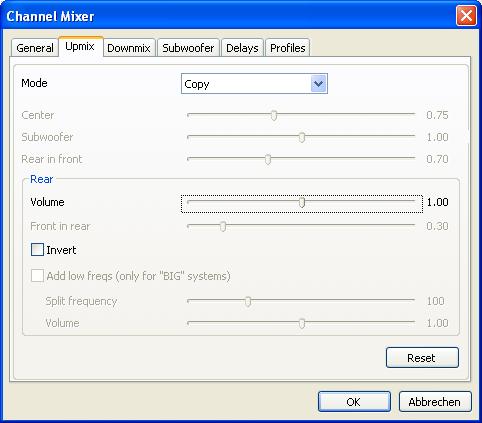

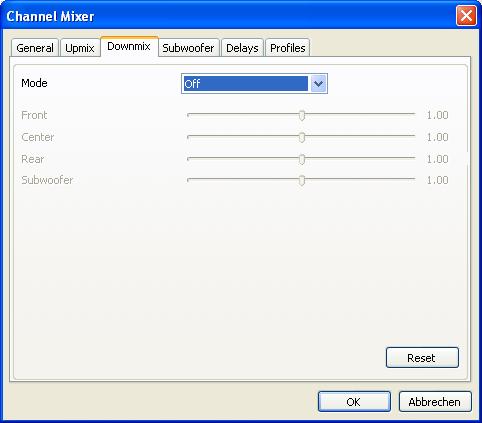

Hierzu wähle ich folgende Einstellung des „Channel Mixer“

http://skipyrich.com/wiki/Foobar2000:Channel_Mixer

(ich gehe einfach die ersten drei Reiter durch)

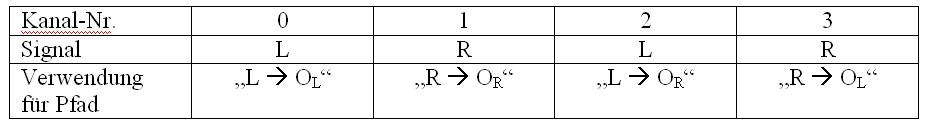

Der Channel Mixer generiert damit (meinen Experimenten zufolge) folgende Kanalbelegung (beginnend mit 0)

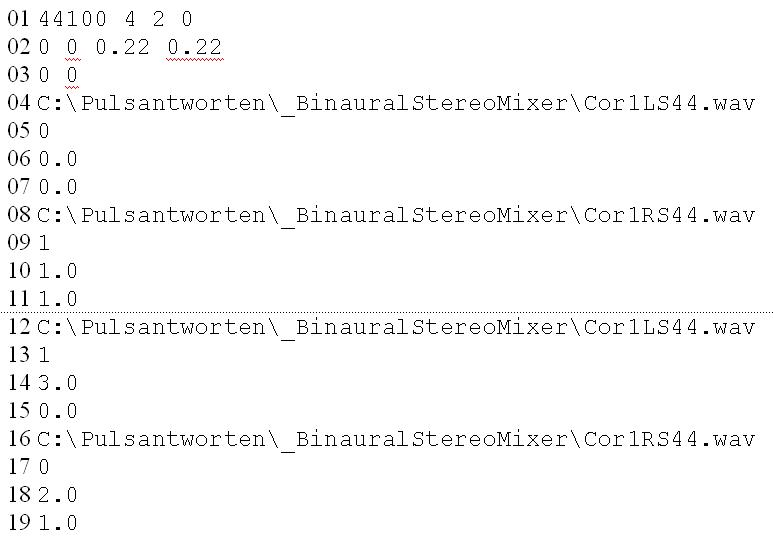

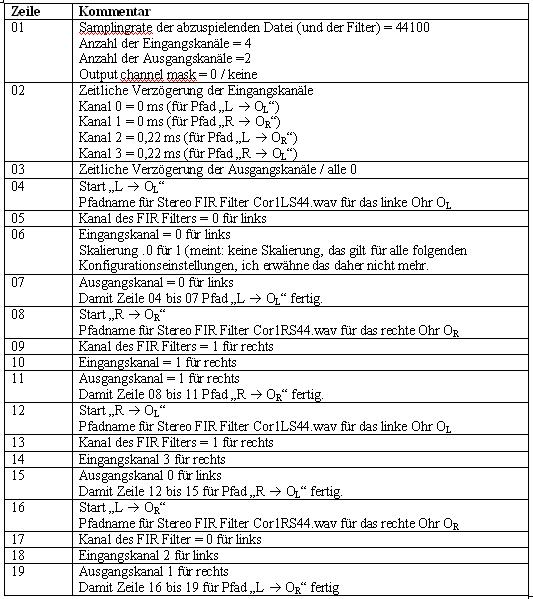

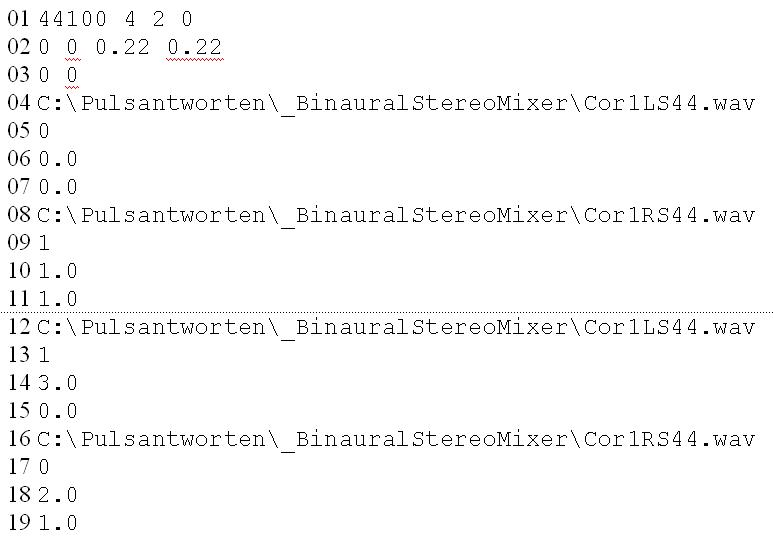

Nun fehlt noch die Konfigurationsdatei für den Convolver VST. Die Syntax ist etwas kryptisch und daher erklärungsbedürftig. Ich habe die Zeilen nummeriert und interpretiere die Eintragungen anschließend. Die Nummern an den Zeilenanfängen gehören natürlich nicht in die Konfigurationsdatei.

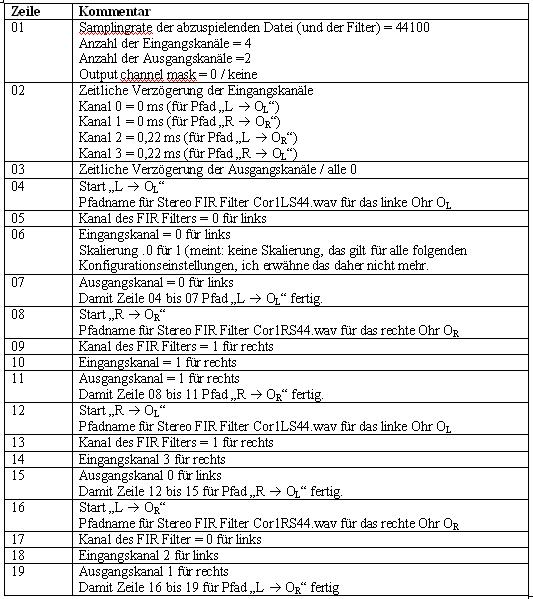

Im foobar DSP Manager sieht die Konfiguration wie folgt aus:

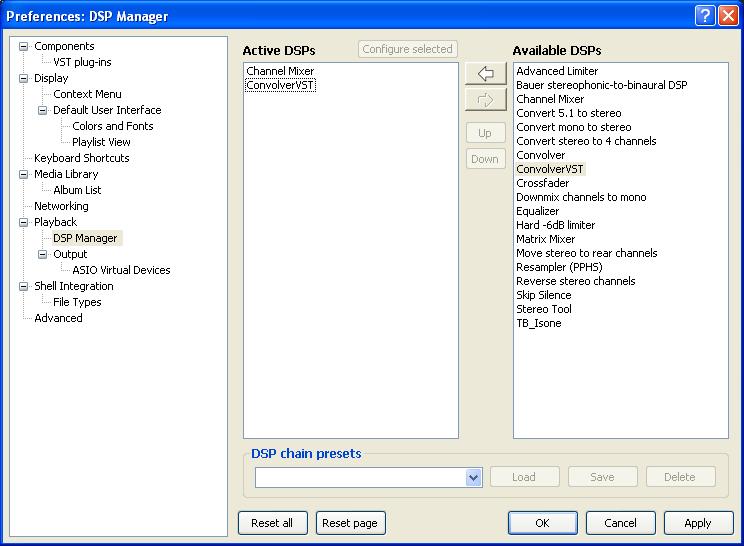

Und nach Laden der oben skizzierten Konfigurationsdatei:

4. Hörergebnis

Hören mit Kopfhörer und mit der Konfiguration wie oben beschrieben. Das Klangbild ist räumlich richtiger, als ohne die Faltung. Die Klangquelle lokalisiere ich nicht mehr in meinem Kopf sondern davor und etwas oberhalb der Stirn. Es ist, als wären meine Lautsprecher eingeschaltet und das „Hüttentheater“ – wie ich das Hören im Nahfeld genannt habe – ist ein wenig nach oben verschoben.

sondern davor und etwas oberhalb der Stirn. Es ist, als wären meine Lautsprecher eingeschaltet und das „Hüttentheater“ – wie ich das Hören im Nahfeld genannt habe – ist ein wenig nach oben verschoben.

Der Preis, den ich für diesen räumlichen Klangeindruck zahle, ist ein gewisser, aber nicht allzu großer Verlust an Details, Genauigkeit und Dynamik. Meine Hoffnung liegt nun darin, dass ich bei der Filtergenerierung viele Fehler gemacht habe und dies verbessern kann.

Viele Grüße

Harald

Liebe Forenten,

nun bin ich wieder einen Schritt weiter: Durch Einsatz von FIR Filter kann ich die in-Kopf-Lokalisation beim Kopfhörer-Hören vermeiden. Was jetzt folgt ist allerdings noch sehr im Versuchststadium. Uli Brüggemann, dem ich die Methode vorab dargestellt habe, hat schon angedeutet, dass der Korrekturfilteransatz falsch ist. Aber der Reihe nach.

Ich verwende im Folgenden wieder die Methode, ein Kochrezept darzustellen. Wie das dann realiter schmeckt, findet man sicher erst beim "Nachkochen" heraus. Vielleicht kommen Euch beim Lesen aber auch Ideen, ohne dass Ihr es explizit nachvollziet. Jedes Feed-back kann hilfreich sein. Und alles eben noch im Versuchsstadium ist, bin ich sehr, sehr daran interessiert, welche Ideen Ihr dazu habt.

Wer von Euch an dieser Fragestellung tieferes Interesse hat, kann sich auch gerne per PN bei mir melden. Meine gesamte Ausrüstung, die ich zum Messen und Abhören benötige, passt durchaus in eine Klappbox (wenn ich die LS mal ausklammere)...

1. Grundbegriffe und Vorgehensweise

Grundsättzlich bin ich mit meiner Kopfhörer Kette sehr zufrieden, was Klangfülle, Transparenz und Detailreichtum betrifft. Was ich verbessern will, ist das räumliche Hören, weil das Orchester mit meiner Kopfhörer-Kette eben in meinem Kopf lokalisiert zu sein scheint. Und das klingt beim AUDEZE nach 100 Musikern im eigenen Kopf (und das ist etwas heftig auch wenn es sehr schön differenziert ist).

Ideen hierzu wurden in diesem Thread ausgetauscht:

http://www.aktives-hoeren.de/viewtopic. ... 7&start=15

Nun folgt der Versuch, meine individuelle „Head Related Transfer Function“ (HRTF) zu messen und durch geeignete FIR Filter beim Abspielen zu berücksichtigen. Dies sollte die „In-Kopf-Lokalisation“ (IKL) vermeiden und zu einem räumlicheren Höreindruck beim Kopf-Hören führen.

Gehen wir dazu mal idealisiert von einer möglichst raum-neutralen Stereo-Abhörsituation mit zwei Lautsprechern aus. Mit dem linken Ohr OL hören wir dann nicht nur das aus dem linken Kanal L stammende Signal „L --> OL“ sondern auch – leicht zeitversetzt und entsprechend durch unsere Anatomie verfremdet – das aus dem rechten Kanal R stammende “R --> OL“. Die HRTF (vgl. etwa http://de.wikipedia.org/wiki/HRTF) charakterisiert also eine Filterwirkung von Kopf, Außenohr, Rumpf etc.

Die Idee ist nun, die HRTF unter Verwendung einer Stereo-Abhörkette zu messen und entsprechende FIR Filter zu generieren, mit denen beim Abspielen die Stereo-Signale dann geeignet gefaltet werden.

Was die zeitliche Verzögerung der Pfade “L --> OR“ und “R --> OL“ betrifft, habe ich auf Basis meines Ohrabstandes und elementaren geometrischen Überlegungen einen Wert von 0,233 ms errechnet und ganz gute Erfahrungen gemacht mit 0,22 ms.

2. Messverfahren

Ich verwende eine Messaufbau wie folgt.

Dazu wurde ich angeregt durch den Aufbau eines älteren Sennheiser Kopfbügelmikrofons MKE 2002:

http://www.sennheiser.com/sennheiser/ol ... 90_Sp3.pdf

Bei der Messung von LogSweeps halte ich das Behringer Messmikro von Hand so, dass der vom jeweiligen Ohr reflektierte Schall gemessen wird, ganz analog zu den Zeichnungen in der Anleitung zum Sennheiser MKE 2002.

Ich benötige für die vier oben skizzierten Pfade zwei Stero-LogSweeps. Ich beschreibe das Verfahren jetzt für das linke Ohr. Für das rechte Ohr geht dann alles analog. Betrachten wir also zunächst den Stereo-Logsweep für das linke Ohr OL. D.h. während der gesamten Messung wird das Mikro ans linke Ohr gehalten. Zuerst kommt das LogSweep Signal aus dem linken und dann aus dem rechten Kanal.

Im Resultat repräsentiert Pulse44L den Pfad „L --> OL“ (rote Kurve) und Pulse44R den Pfad „R --> OL“ (die grüne Kurve logischerweise mit geringerem Pegel).

Nun kenne ich mit (((acourate))) nicht sehr gut aus. Ich verwende daher auch für meinen Zweck die Room-Macros, auch wenn sie sicher für einen anderen Zweck entwickelt wurden. Gerade hier hoffe ich auf Tipps von den (((acourate))) Experten unter Euch.

Resultat von Room Macro 1 sind geglättete Pulsefunktionen.

Nun verwende ich die Macros 2 (Target Curve Design) und 3 (Inversion) nicht, da ich ja die spezifischen Eigenschaften der Pulsefunktionen nicht korrigieren sondern eben für die FIR Filter verwenden will. Ich behelfe mir daher damit, die Ergebnisse aus Macro 1 umzukopieren.

Pulse44Lmp.dbl --> Pulse44Linv.dbl und

Pulse44Rmp.dbl --> Pulse44Rinv.dbl

und tue so, als hätte Macro 3 ein entsprechendes Ergebnis geliefert. Anschließend wende ich Macro 4 (Filter Generation) an, um die FIR Filter zu generieren.

Die resultierenden Filter repräsentieren dann die Pfade für das linke Ohr OL. Damit ich sie später unterscheiden kann von denjenigen fürs rechte Ohr, kopiere ich sie ebenfalls um, also z.B. Cor1S44.wav --> Cor1LS44.wav

Der Vollständigkeit halber liefert Macro 5 (Test Convolution) folgendes Resultat:

Dieselbe Prozedur für rechte Ohr OR (also neues Projekt, ebenfalls Stereo-LogSweep, Glätten, Filter bestimmen) liefert die Filter fürs rechte Ohr, welche ich entsprechend umbenenne, z.B. Cor1S44.wav --> Cor1RS44.wav.

3. Wiedergabe

Für die Wiedergabe verwende ich den ConvolverVST. Die Pfade „L --> OL“ und „R --> OR“ könnten wie normale Stereo-FIR verwendet werden. Für die Pfade „R --> OL“ und „L --> OR“ dagegen benötige ich eine leichte zeitliche Verzögerung. Denn das entfernter liegende Ohr bekommt das Signal ja später. Um das dem Convolver VST beizubringen, verwende ich das foobar plugin „Channel Mixer“ und generiere damit aus dem Stereo-Signal ein Vier-Kanal-Signal.

Hierzu wähle ich folgende Einstellung des „Channel Mixer“

http://skipyrich.com/wiki/Foobar2000:Channel_Mixer

(ich gehe einfach die ersten drei Reiter durch)

Der Channel Mixer generiert damit (meinen Experimenten zufolge) folgende Kanalbelegung (beginnend mit 0)

Nun fehlt noch die Konfigurationsdatei für den Convolver VST. Die Syntax ist etwas kryptisch und daher erklärungsbedürftig. Ich habe die Zeilen nummeriert und interpretiere die Eintragungen anschließend. Die Nummern an den Zeilenanfängen gehören natürlich nicht in die Konfigurationsdatei.

Im foobar DSP Manager sieht die Konfiguration wie folgt aus:

Und nach Laden der oben skizzierten Konfigurationsdatei:

4. Hörergebnis

Hören mit Kopfhörer und mit der Konfiguration wie oben beschrieben. Das Klangbild ist räumlich richtiger, als ohne die Faltung. Die Klangquelle lokalisiere ich nicht mehr in meinem Kopf

Der Preis, den ich für diesen räumlichen Klangeindruck zahle, ist ein gewisser, aber nicht allzu großer Verlust an Details, Genauigkeit und Dynamik. Meine Hoffnung liegt nun darin, dass ich bei der Filtergenerierung viele Fehler gemacht habe und dies verbessern kann.

Viele Grüße

Harald

Tolle Idee und toller Bericht, Harald!

Ich verstehe dich so, dass du die Eigenschaften deiner Hörumgebung, also einschließlich deines Hörraumes sowie der Anatomie deines Kopfes per FIR-Filter in das Audiosignal falten möchtest.

Das erste Ergebnis scheint dir ja schon sehr gut zu gefallen. Das mit der mangelnden Detailauflösung kann meines Erachtens damit zusammen hängen, dass du dich (bislang) keiner Zielkurve bedienst, denn die könnte helfen, unerwünschte Raumeinflüsse auszublenden.

Viele Grüße

Rudolf

Ich verstehe dich so, dass du die Eigenschaften deiner Hörumgebung, also einschließlich deines Hörraumes sowie der Anatomie deines Kopfes per FIR-Filter in das Audiosignal falten möchtest.

Das erste Ergebnis scheint dir ja schon sehr gut zu gefallen. Das mit der mangelnden Detailauflösung kann meines Erachtens damit zusammen hängen, dass du dich (bislang) keiner Zielkurve bedienst, denn die könnte helfen, unerwünschte Raumeinflüsse auszublenden.

Viele Grüße

Rudolf

-

nihil.sine.causa

- Aktiver Hörer

- Beiträge: 1506

- Registriert: 28.07.2011, 12:31

- Wohnort: Bonn

Hallo Rudolf,Rudolf hat geschrieben: Ich verstehe dich so, dass du die Eigenschaften deiner Hörumgebung, also einschließlich deines Hörraumes sowie der Anatomie deines Kopfes per FIR-Filter in das Audiosignal falten möchtest.

Ja das ist richtig. Eigentlich wäre es mir lieber, ich könnte die HRTF (Kopf, Ohren etc) unabhängig vom Hörraum messen. Das würde allerdings einen schalltoten Raum zur Messumg voraussetzen, den ich nicht habe.

Aber auch das Messen in gut abgestimmten Hörumgebungen hätte seinen Reiz. Man kann "seine" Hörsituation auch über Kopfhörer simulieren (z.B wenn man andere nicht stören möchte).

Ich habe hier keine Zielkurve verwendet, weil ich den Frequenzgang ja gerade so verbiegen möchte, dass meine HRTF darin codiert ist. Meine im Nahfeld betriebenen Abaküsse sind für den vorliegenden Zweck erst einmal linear genug. Also verzichte ich auf Raumkorrektur.Rudolf hat geschrieben: Das erste Ergebnis scheint dir ja schon sehr gut zu gefallen. Das mit der mangelnden Detailauflösung kann meines Erachtens damit zusammen hängen, dass du dich (bislang) keiner Zielkurve bedienst, denn die könnte helfen, unerwünschte Raumeinflüsse auszublenden.

(Ich hatte auch schon Experimente gemacht mit Zielkurven, die Hörergebnisse waren aber überhaupt nicht befriedigend.)

Aber irgendetwas stimmt noch nicht. Vom Höreindruck her ist die Klangquelle zwar nun scheinbar außerhalb des Kopfes, aber das Klangbild ist "verschränkt". Das kann an der ungewöhnlichen Messmethode liegen (wir hören ja anders als ich messe); hier könnte ein Mikrophon im Ohr helfen. Das könnte aber auch genausogut daran liegen, dass ich Ulis Toolbox (insbes. Makro 1 und 4) missbrauche, denn das ist ja auf Kaumkorrektur hin ausgelegt. Was diesen Punkt betrifft bin ich noch etwas ratlos.

Gruß

Harald

Hallo Harald,

)

)

Aber es sollte doch mit Hilfe von Acourate ein Leichtes sein, auch den Rest-Raum herauszurechnen. Also keine Raumkorrektur, sondern eher eine "Raumausblendung".

Dazu müsstest du zwei Messungen machen:

1. die beiden Messungen am Ohr (hast du schon gemacht)

2. die beiden Messungen an denselben Positionen, jedoch ohne deinen Kopf

Aus diesen beiden Messungen ziehst du die Differenz und schwupp, weg ist der Raum! (Wem das verdächtig nach Ion Tichy klingt, der beweist Kennerschaft).

Was meinen unsere Acourate-Spezialisten?

Viele Grüße

Rudolf

Natürlich! (Meine Antwort auf deinen Beitrag habe ich offenkundig zu früh morgens geschrieben.nihil.sine.causa hat geschrieben:Ich habe hier keine Zielkurve verwendet, weil ich den Frequenzgang ja gerade so verbiegen möchte, dass meine HRTF darin codiert ist. Meine im Nahfeld betriebenen Abaküsse sind für den vorliegenden Zweck erst einmal linear genug. Also verzichte ich auf Raumkorrektur.

Aber es sollte doch mit Hilfe von Acourate ein Leichtes sein, auch den Rest-Raum herauszurechnen. Also keine Raumkorrektur, sondern eher eine "Raumausblendung".

Dazu müsstest du zwei Messungen machen:

1. die beiden Messungen am Ohr (hast du schon gemacht)

2. die beiden Messungen an denselben Positionen, jedoch ohne deinen Kopf

Aus diesen beiden Messungen ziehst du die Differenz und schwupp, weg ist der Raum! (Wem das verdächtig nach Ion Tichy klingt, der beweist Kennerschaft).

Was meinen unsere Acourate-Spezialisten?

Viele Grüße

Rudolf

-

uli.brueggemann

- Aktiver Hersteller

- Beiträge: 4659

- Registriert: 23.03.2009, 15:58

- Wohnort: 33649

- Kontaktdaten:

Ich habe mich noch nicht wirklich mit der Thematik beschäftigt. Falls aber die Makros zum Erfolg führen würden, wäre dies m.E. eher zufällig.Rudolf hat geschrieben: Was meinen unsere Acourate-Spezialisten?

Klar ist, dass beim Kopfhörer linkes und rechtes Ohr ihr Signal sauber unabhängig voneinander bekommen. Das ist bei LS nicht der Fall. Das Signal des rechten LS kommt liinks an, dabei ist auch der Frequenzgang verändert (beim linken LS ist es entsprechend umgekehrt, es reicht eine Seite zu beschreiben.)

Also wäre dieses Verhalten vielleicht nachzubilden. Das rechte Signal kommt unverändert rechts zum Kopfhörer, links aber gefiltert. Das Filter ist zu ermitteln als Unterschied zwischen den bei der HRTF-Aufnahme ermittelten Signalen. F = HRTF links // HRTF rechts (// meint hier De-Convolution). Dazu ist also von HRTF rechts die Inverse zu bilden, wozu das Signal sinnvollerweise vorzubehandeln ist. Hier kommen dann ähnliche Funktionen wie bei Makro1 ins Spiel. Wichtig ist, dass die Inverse auch eine zeitliche Komponente beinhaltet, nur ein geänderter Frequenzgang wird nicht reichen.

Das alles ist so mal platt dahingeschrieben. Die Funktionen sind in Acourate auch enthalten (TD (time domain) und FD (frequency domain)-Functions), man muss die, natürlich, (nur) noch in der richtigen Reihenfolge mit richtigen Parametern anwenden.

Ziel wäre es dann, quasi das Übersprechverhalten der LS nachzubilden. Ob das dann den gewünschten Vorne-Effekt gibt, kann ich nicht wirklich einschätzen. Vermutlich eher nicht. Weil wir beim LS-Hören ja auch unseren Kopf bewegen und damit ändert sich auch unmittelbar das empfangene Signal. Beim Kopfhörer passiert da ja nichts, wir müssten ein zusätzliches Head-Tracking mit sich anpassenden Filtern realisieren.

Grüsse, Uli

-

wgh52

- Aktiver Hörer

- Beiträge: 5647

- Registriert: 25.01.2008, 15:17

- Wohnort: Schweitenkirchen

- Kontaktdaten:

Hallo Uli,

ich finde diese Sache extrem spannend! Ich bin wegen nervender im Kopf Lokalisation ja "inaktiver Kopfhörer".

Wie wär's denn, die Sache in zwei Schritten anzugehen, also erstmal ohne Kopfstellungsanpassung, um das Prinzip zum Laufen zu bekommen?

Viele, ich eingeschlossen, würden sicher schon mit der Version ohne Kopfstellungsanpassung viel lieber "Kopfhören"! Einzig schon wegen der "ausser Kopf Lokalisation". Und: Beim heutigen Kopfhören gibt's ja auch keine Kopfstellungsanpassung, höchstens einfaches cross-feed. Optimierung in Richtung wahrgenommener Raumtiefe halte ich für viel wichtiger!

Bitte weiterentwickeln!

Gruß,

Winfried

2187

ich finde diese Sache extrem spannend! Ich bin wegen nervender im Kopf Lokalisation ja "inaktiver Kopfhörer".

Wie wär's denn, die Sache in zwei Schritten anzugehen, also erstmal ohne Kopfstellungsanpassung, um das Prinzip zum Laufen zu bekommen?

Viele, ich eingeschlossen, würden sicher schon mit der Version ohne Kopfstellungsanpassung viel lieber "Kopfhören"! Einzig schon wegen der "ausser Kopf Lokalisation". Und: Beim heutigen Kopfhören gibt's ja auch keine Kopfstellungsanpassung, höchstens einfaches cross-feed. Optimierung in Richtung wahrgenommener Raumtiefe halte ich für viel wichtiger!

Bitte weiterentwickeln!

Gruß,

Winfried

2187

-

nihil.sine.causa

- Aktiver Hörer

- Beiträge: 1506

- Registriert: 28.07.2011, 12:31

- Wohnort: Bonn

Hallo Uli,uli.brueggemann hat geschrieben: Das rechte Signal kommt unverändert rechts zum Kopfhörer, ...

da bin ich mir nicht so sicher. Denn wenn ich den Logsweep nach Ohrreflexion R --> OR vergleiche mit einem ohne eine solche Reflexion, stelle ich doch gravierende Unterschiede fest. Also auch das rechte Signal, das ins rechte Ohr soll, müsste m.E. modifiziert werden. Aber sei's drum, solche Vergleiche sind ja schnell gemacht, wenn die Filter erst einmal vorliegen.

Gerne fuchse ich mich da tiefer rein (etwas für die kommenden langen Winterabende)uli.brueggemann hat geschrieben: Das Filter ist zu ermitteln als Unterschied zwischen den bei der HRTF-Aufnahme ermittelten Signalen. F = HRTF links // HRTF rechts (// meint hier De-Convolution). Dazu ist also von HRTF rechts die Inverse zu bilden, wozu das Signal sinnvollerweise vorzubehandeln ist. Hier kommen dann ähnliche Funktionen wie bei Makro1 ins Spiel. Wichtig ist, dass die Inverse auch eine zeitliche Komponente beinhaltet, nur ein geänderter Frequenzgang wird nicht reichen.

Hallo Winfried,wgh52 hat geschrieben:Wie wär's denn, die Sache in zwei Schritten anzugehen, also erstmal ohne Kopfstellungsanpassung, um das Prinzip zum Laufen zu bekommen?

Viele, ich eingeschlossen, würden sicher schon mit der Version ohne Kopfstellungsanpassung viel lieber "Kopfhören"! Einzig schon wegen der "ausser Kopf Lokalisation".

ich stimme Dir zu, die Kopfstellungsanpassung (schönes Wort) wäre ein zweiter Schritt. Sie ist übrigens am Markt erhältlich. Vgl. hier http://www.aktives-hoeren.de/viewtopic. ... 877#p33877

Dieser "Realiser A8" ist für meinen Geschmack zu sehr Black Box und für 2500 € etwas zu teuer um es eben mal auszuprobieren. Die Kopfstellungsanpassung wird m.E. erst dann wirklich interessant, wenn man Surround z.B. 5.1 auf Stero Kopfhörer herunterprojiziert.

Ich bin davon überzeugt, dass es mit dem eingeschlagenen Weg gehen muss. Und wenn wir einmal verstanden haben, wie es genau geht, haben wir alle Einstellungen selbst im Griff.

Gruß

Harald